エッジAIで大規模言語モデル (LLM) の実行処理が可能に

近年、エッジコンピューターの処理能力が飛躍的に向上し、大規模言語モデル(LLM)をエッジデバイスに搭載することが現実的になってきました。エッジデバイスとは、データが生成される現場(エッジ)で直接データ処理を行うデバイスのことを指します。これには、スマートフォン、IoTセンサー、ドローン、ロボットなどが含まれます。エッジコンピューティングは、データを中央のサーバーに送信することなく、エッジデバイス上で処理することで、リアルタイムな応答性やプライバシー保護の強化、ネットワーク帯域幅の節約といった利点をもたらします。

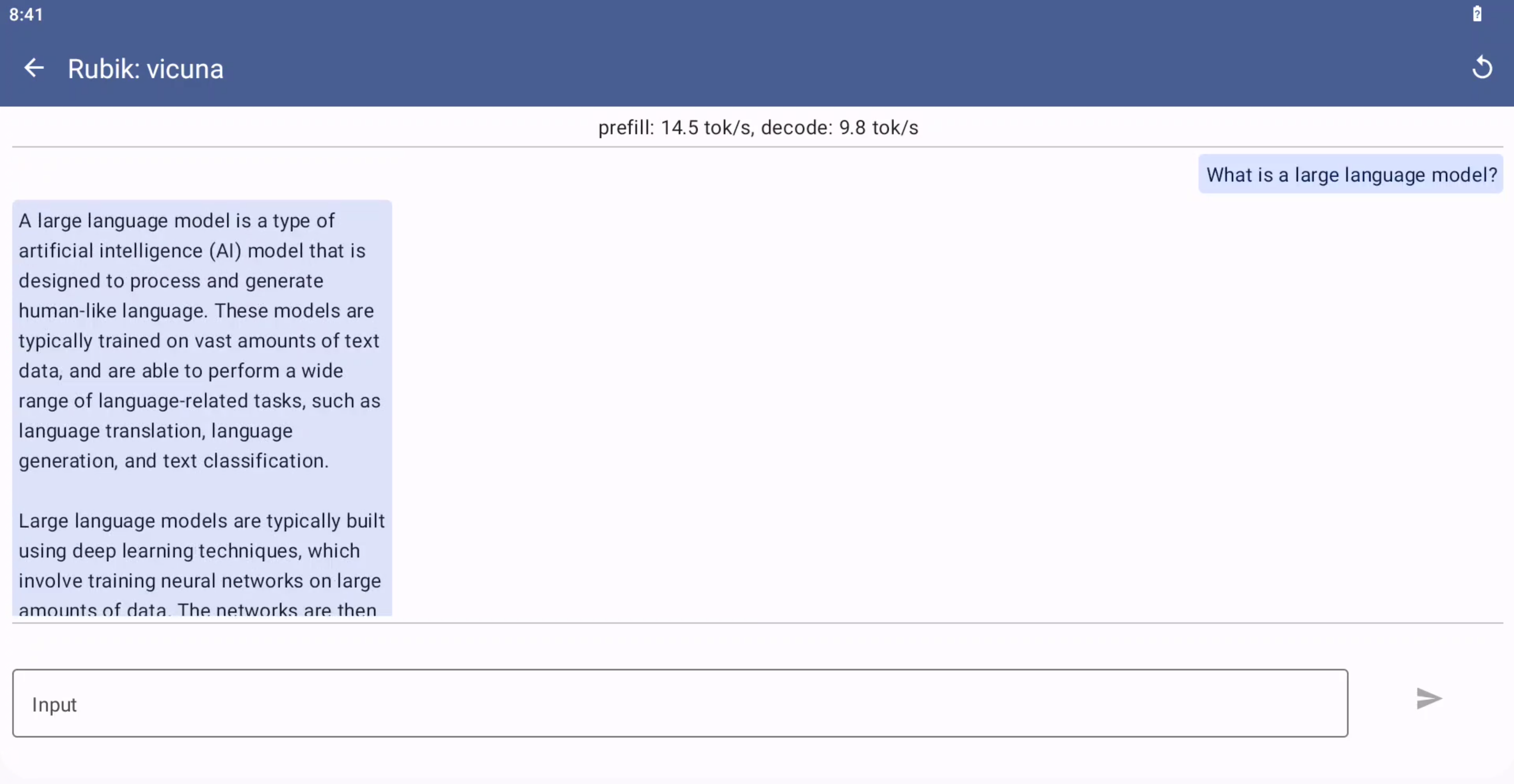

本ページでは、LLMをエッジデバイスに搭載することの重要性や利点、課題について解説するとともに、Qualcommのデバイス上でおこなった

対話型デモの事例を紹介します。

大規模言語モデル (LLM) の概要

LLMとは

大規模言語モデル(LLM)は、膨大な量のテキストデータを基に訓練された機械学習モデルで、人間の言語を理解し生成する能力を持ちます。

例えば、GPT-4やBERTは、その高度な自然言語処理(NLP)能力で知られています。これらのモデルは、テキスト生成、翻訳、質問応答などの多岐にわたるタスクをこなすことができ、AI研究や実務の現場で広く活用されています。

LLMの利点と活用例

LLMは非常に多様な応用が可能です。例えば、テキスト生成では、ニュース記事の自動生成やクリエイティブライティング支援、翻訳では多言語間のスムーズなコミュニケーション、質問応答ではカスタマーサポートの自動化などが挙げられます。また、ヘルスケア分野では患者の症状に基づいた診断サポート、製造業では故障予測やメンテナンス計画の最適化、IoTではデータ解析や異常検知に役立っています。

エッジデバイスでのLLMの利点と課題

利点

エッジデバイス上でLLMを実行することには多くの利点があります。まず、リアルタイム処理が可能になるため、データを中央サーバーに送信して処理結果を待つ必要がなくなります。これにより、応答時間が劇的に短縮され、ユーザーエクスペリエンスが向上します。また、データがエッジデバイス内で処理されるため、プライバシー保護が強化されます。さらに、ネットワーク帯域幅の節約にも寄与し、大量のデータを送信することなく、効率的にデータ処理を行うことができます。

課題

一方で、エッジデバイスでLLMを実行するにはいくつかの課題もあります。エッジデバイスは通常、計算リソースやメモリが限られているため、LLMのような大規模で計算集約的なモデルを効率的に実行するのは困難です。また、エネルギー消費も大きな課題となります。エッジデバイスはバッテリー駆動であることが多く、省電力での動作が求められます。さらに、モデルの更新や管理も容易ではなく、新しいデータやアルゴリズムに基づいてモデルを継続的に改善するための仕組みが必要です。

QualcommのエッジデバイスでLLMモデルを動かしてみる

今回はQualcommのエッジデバイス上で実行できるように開発したエッジLLMのアプリケーションを試してみました。テスト環境として、Qualcomm QCS8550を搭載した開発ボードを使用し、キーボードを用いた対話型のアプリケーションを実行します。インターネットには接続しておらず、エッジデバイスのみで処理を行い応答を出力します。

アプリケーションの起動: インストールしたアプリケーションを起動し、キーボードを用いた対話型インターフェースにアクセスします。

対話の開始: キーボードを使って質問を入力し、LLMモデルが生成する応答を観察します。例えば、自然言語での質問に対してどのような回答が返ってくるかを確認します。

このように、エッジデバイスでもLLMモデルを実行できるようになってきており、さまざまなアプリケーションへの活用の可能性が広がっています。組込み製品へのLLM実装を検討されているお客様は、ぜひQualcommのプラットフォームをご検討いただければ幸いです。

Qualcommは今後もAI分野に注力し、より高性能で使いやすいデバイスやソリューションを提供していく見込みです。今回ご紹介した言語モデル以外にも画像や映像を用いたエッジAIの導入へもご検討いただけますので、ぜひご相談ください。

本ページで紹介したデバイスの詳細情報はこちら

お問い合わせ

本ページの内容に関するご質問や製品詳細情報をご希望の方はこちらからお問い合わせください。