はじめに

NVIDIAの次世代エッジAIプラットフォーム “NVIDIA® Jetson Thor™” が正式リリースされました。本記事では、NVIDIA® Jetson AGX Thor™ 開発者キットの性能概要を簡単に紹介し、ホストPC不要のUSBインストール(Jetson ISO)を中心に、Docker・CUDA®・NVIDIA JetPack SDKのセットアップ、セットアップ時の注意点、DockerコンテナでのCUDAを用いたAI推論動作確認までを体系的に解説します。

この記事のゴールと対象

ゴール

Jetson Thor(Jetson AGX Thor 開発者キット)の概要把握、セットアップ手法概要の理解、USBインストールによる初期セットアップの完了、セットアップした環境でAI推論を試す。

対象

はじめてThorを触る開発者 / PoC担当、NVIDIA Jetson Orin™世代からの移行検討者

本記事で扱う範囲

- Jetson AGX Thor 開発者キットの概要

- セットアップの全体像

- USBインストールの流れ

- Docker・CUDA・JetPack SDKの導入

- AI推論の動作確認

1章. Jetson Thorとは(性能概要・位置づけ)

Jetson Thor は、物理AI / ロボティクスのために設計されたエッジAIプラットフォームです。

Jetson AGX Thor 開発者キットは、卓越したパフォーマンスと拡張性を提供するヒューマノイドロボティクスのための究極のプラットフォームです。最先端のコンピューティングパフォーマンス、広範なI/Oオプション、フルスタックのソフトウェアで、次世代のアプリ開発をアシストします。

Jetson AGX Thor 開発者キットの主なスペック

- AI演算性能:最大 2070 TFLOPS(FP4-Sparas条件下での理論値であり、実アプリケーションでは異なる場合があります)

- GPU:NVIDIA Blackwell アーキテクチャー(第5世代Tensor Core搭載)

- CPU:14コア Arm® Neoverse® -V3AE

- メモリー:128GB LPDDR5X(273GB/s)

- ネットワーク:1x 5GBe RJ45 connector、1x QSFP28 (4x 25 GbE)

- 従来のAGX Orin世代比でAI性能7.5倍、電力効率3.5倍

2章. セットアップ方法の概要

Jetson AGX Thor 開発者キットのセットアップは、公式に3つの方法が提示されています。はじめに全体像を把握し、その後に本記事のメインであるJetson ISO(USBインストール)について詳説していきます。

※SDKマネージャー、フラッシュスクリプトでのインストール手順については、7章の “Appendix” をご覧ください。

|

種類 |

概要 |

詳細リンク |

|

Jetson ISO (USBインストール) |

USBメモリーからインストーラーを起動して導入する。 初心者を含めた全員にオススメ。 |

Quick Start Guide — Jetson AGX Thor Developer Kit - User Guide |

| SDKマネージャー |

ホストUbuntu PCのSDK ManagerからGUIでフラッシュ。 Ubuntu PCユーザー向け。 |

Install Jetson Software with SDK Manager — SDK Manager |

| フラッシュスクリプト | CLIスクリプトでフラッシュ。製品開発者向け。 | Quick Start — NVIDIA Jetson Linux Developer Guide |

[表1]各セットアップ手順、概要、詳細リンク

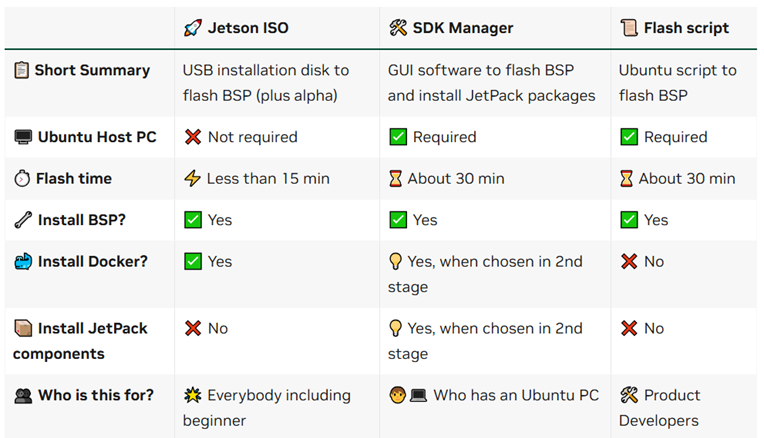

以下の画像には、それぞれのセットアップの特徴とインストールされる構成要素がまとまっています。

3章. セットアップ実行(Jetson ISO:USBインストール)

- USBインストールはJetPack 7.0で導入された新しい手順です。

- ホストPC不要で、デスクトップPCやノートPCにUbuntuをインストールする手順と同様の手順でセットアップが可能です。

- USBインストールには、Jetsonを普通のPCのように使用する「モニター接続インストール」、ラップトップPCとJetsonを繋いでJetsonをサーバーのように使用する「ヘッドレスインストール」という2つのスタイルがあります。ご利用環境や用途に応じて、いずれかの方法を選択してください。

公式のクイックスタートガイド(Quick Start Guide — Jetson AGX Thor Developer Kit - User Guide)内でわかりやすく解説されているので、こちらのクイックスタートガイドと照らし合わせながら以下の手順(3.1~3.2)を見ることを推奨します。

3.1 必要物

- Jetson AGX Thor 開発者キット

- PC(Windows / Mac / LinuxいずれかのOSで、容量に25GB以上の空きがあるもの)

- USBメモリー(16GB以上のもの)

- モニター(モニター接続インストール利用時)

- キーボード(モニター接続インストール利用時)

- マウス(モニター接続インストール利用時)

3.2 事前準備

- ISOの入手:公式のクイックスタートガイドのページ内にある、Jetson ISOをPCにダウンロード (こちらのリンクからISOをダウンロードできます:https://developer.nvidia.com/downloads/embedded/L4T/r38_Release_v2.0/release/jetsoninstaller-0.2.0-r38.2-2025-08-22-01-33-29-arm64.iso)

- ブータブルインストール用 USB メモリーの作成:balenaEtcherを使用してISOをPCからUSBメモリーに書き込む(こちらのリンクからbalenaEtcherをダウンロードできます:https://etcher.balena.io/#download-etcher )

3.3 インストール手順(ダイジェスト)

本記事では、「モニター接続インストール」実行時の様子を載せております。

1. Jetson AGX Thor 開発者キットにディスプレイ / キーボード・マウス / ブータブルインストール用USBメモリーを接続した後、電源投入

(2つあるUSB-C portのどちらを使用しても問題ありません)

2. “GNU GRUB” の画面で、“Jetson Thor options” → “Flash Jetson Thor AGX Developer Kit on NVMe 0.2.0-r38.1” を選択すると、インストールが始まります

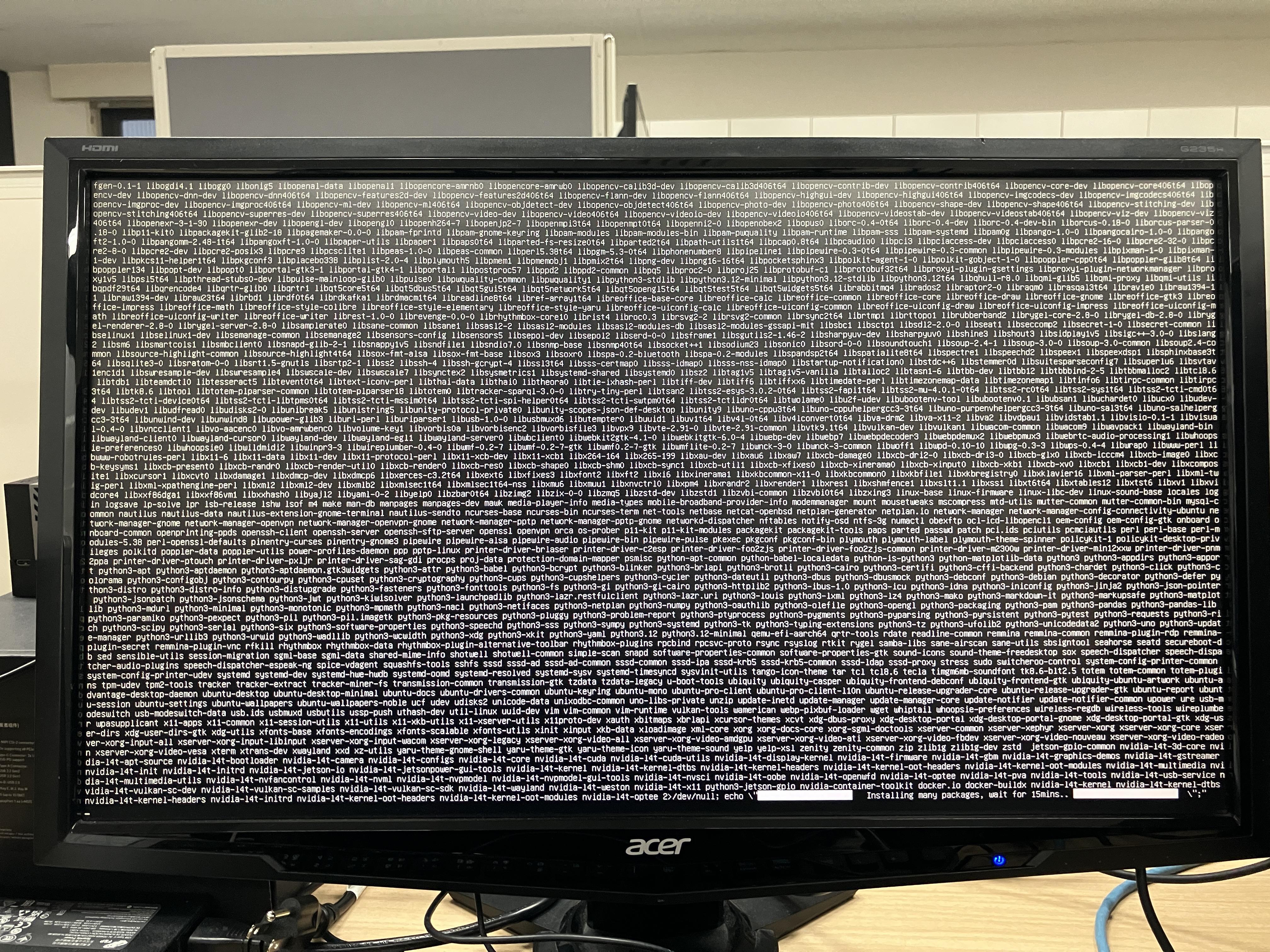

💡以下の画像のように、途中で画面に大量の文字が表示され、一時的にフリーズしたように見える場合があります。

正常な動作ですので、15分程度で次の画面に進みます(右下にwait for 15mins..と書いてあります)

3. インストールは15分ほどで終了し、再起動がかかります。

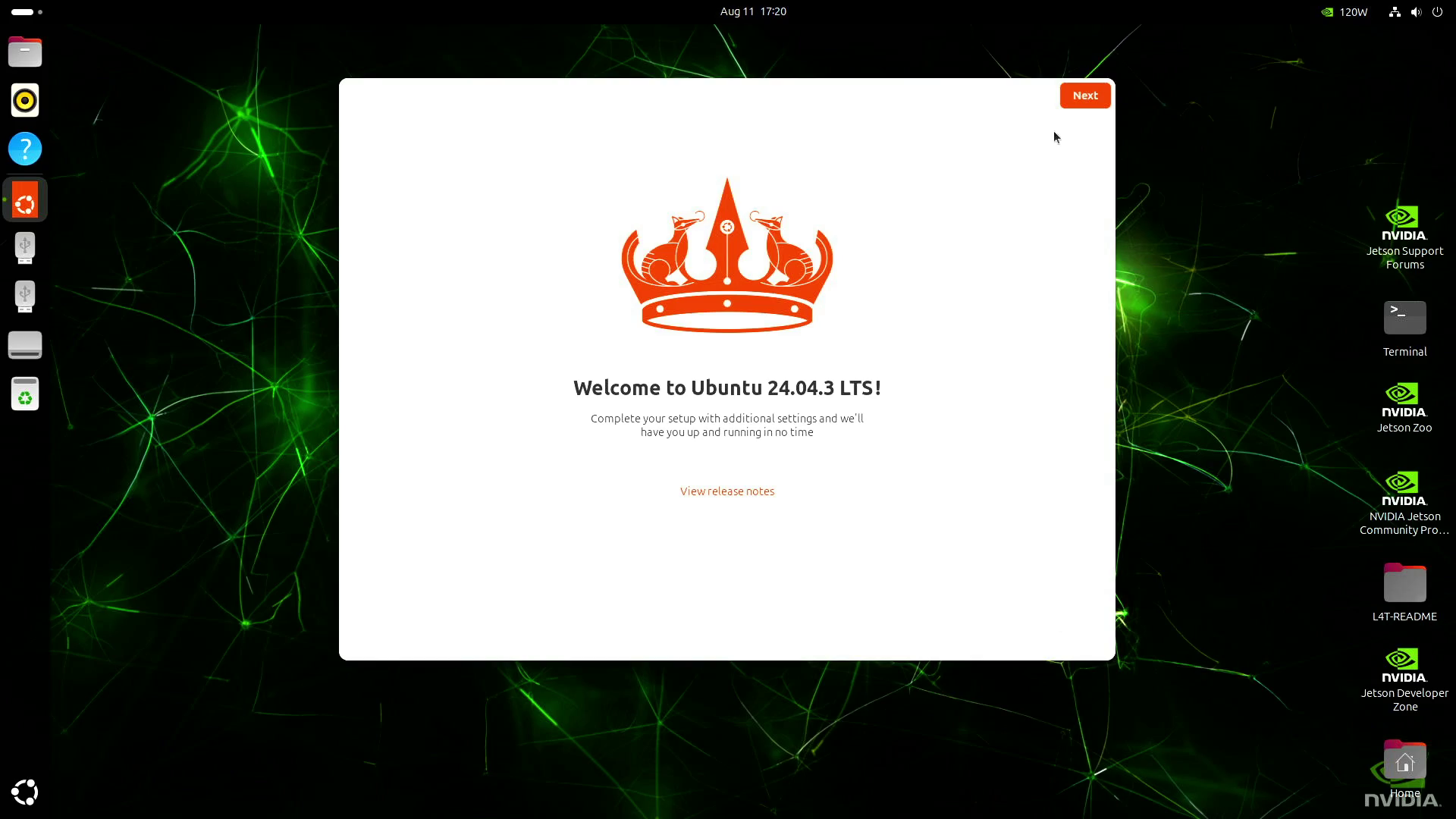

4. 初期設定が始まるので、画面の指示に従って設定を終えてください。

5. 設定完了をもって、セットアップは完了となります。

3.4 イメージ書き込み作業時のQ&A

Q:USB-C portが2つあり、電源投入にどちらを使ってよいかわからない

A:どちらのUSB-Cポートでもご利用いただけます。

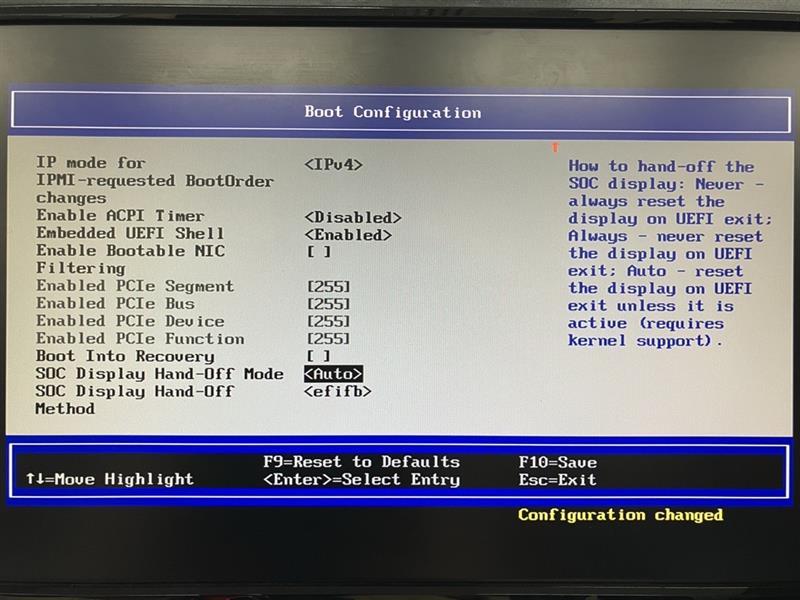

Q:すでに一度セットアップ済みの個体に再度USBインストールしたい

A:UEFI 設定で SOC Display Hand-Off Mode を “Auto”、SOC Display Hand-Off Method を “efifb” に戻す必要があります(初回インストール後は “Never” に切り替わるため)。詳細な手順は、公式ドキュメントをご参照ください(Re-enable USB stick installation — Jetson AGX Thor Developer Kit - User Guide)。

Q:ヘッドレスインストールでUEFI文字化け / 描画不具合が起こる

A:UEFI 38.0.0(工場出荷時のフラッシュ)における既知問題とされています。暫定的な解決策は、蓋カバーの後ろにあるDebug-USB経由でシリアル接続し、PuTTY/Terminal/minicom(OSによって異なります)からUEFI操作をすることとされています。UEFIファームウェアが、38.1/38.2に更新済みであればすでに解消されています(初回セットアップ時に自動でファームウェアアップデートが入ります)。詳細な手順は、公式ドキュメントをご参照ください(Headless installation on UEFI 38.0.0 — Jetson AGX Thor Developer Kit - User Guide)。

4章. Docker / CUDA / JetPack SDKの導入

4.1 方式別の“インストール済み / 未インストール”の整理

表3のように、セットアップ方式ごとのDocker / CUDA / JetPack SDKのインストール有無が異なります。

※CUDAはJetPack SDKに含まれていますが、公式ドキュメントの構成と照らし合わせて理解しやすくするため、本記事ではCUDAとJetPackを分けて解説します。

|

|

Jetson ISO |

SDKマネージャー |

フラッシュスクリプト |

|

Docker |

✅ Yes |

💡途中で選択していればインストール済み |

❌ No |

|

CUDA |

❌ No |

💡途中で選択していればインストール済み |

❌ No |

|

JetPack SDK |

❌ No |

💡途中で選択していればインストール済み |

❌ No |

[表3] 3章までのセットアップ後の状況

※ 5章. AI推論の動作確認 は、Dockerのみのセットアップでも動かすことが可能です。

4.2 Docker(コンテナ基盤)

Dockerとは、アプリケーションとライブラリなどの依存関係をコンテナという軽量な単位でまとめ、どの環境でも同じ動作を再現できる仮想化技術です。

GPU対応のAI環境をコンテナで再現することで、開発・デプロイの互換性を確保できます。

こちらのガイドに従っていただくことで、インストールからコンテナの動作テストが行えます(Docker Setup — Jetson AGX Thor Developer Kit - User Guide)

⚠️Jetson ISO(USBインストール)でセットアップを行った際でも、上記ページ内Step 2のコマンド実行が必要になります。以下、Step 2で実行するコマンドです。

# 以下のコマンドで、既定ランタイムをnvidiaに指定

udo apt install -y jq

sudo jq '. + {"default-runtime": "nvidia"}' /etc/docker/daemon.json | \

sudo tee /etc/docker/daemon.json.tmp && \

sudo mv /etc/docker/daemon.json.tmp /etc/docker/daemon.json

# /etc/docker/daemon.jsonを確認して以下の記載があるか確認。無ければ以下に倣って変更。

$ cat /etc/docker/daemon.json

{

"runtimes": {

"nvidia": {

"args": [],

"path": "nvidia-container-runtime"

}

},

"default-runtime": "nvidia"

}

# sudo不要でdocker実行できるようにユーザーをグループに追加

sudo usermod -aG docker $USER

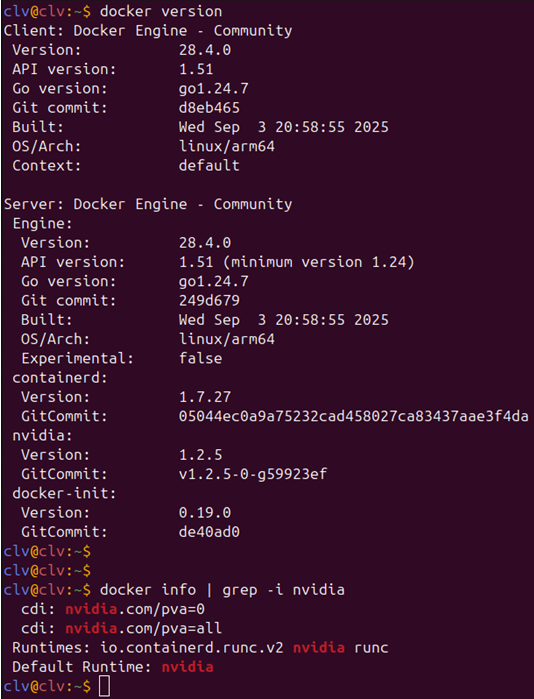

newgrp docker以下のコマンドでDockerとnvidia-container-toolkit がセットアップできているか確認できます。

# Dockerのバージョン確認

docker version# nvidia-container-toolkit がインストールされているか確認

docker info | grep -i nvidia

図のような出力となれば成功です。Dockerコンテナ内でGPUを使用できるようになりました。

4.3 CUDA

CUDA(Compute Unified Device Architecture)は、NVIDIA GPUで並列計算をおこなうためのプラットフォームです。JetsonのGPUを使ってAI推論や学習を高速化するためには必須となります。

- CUDA 対応コンテナの使用(Jetson自体にインストールしてなくてもOK)

- CUDA Toolkitをネイティブにインストール(Jetson自体にインストールする)

どちらの方法を選ぶかは、ご自身の環境に合わせてご判断ください。

⚠️CUDA Toolkitは、次節 “Jetpack SDK” でもインストールされます。

⚠️CUDA Toolkitをネイティブにインストールする際には、以下のコマンドでパスの設定をおこなう必要があります。

Echo “export PATH=/usr/local/cuda/bin:$PATH” >> ~/.bashrc

echo “export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH” >> ~/.bashrc

source ~/.bashrc4.4 JetPack SDK

JetPack SDKは、Jetson向けにCUDA ToolkitやcuDNN、TensorRTなどをまとめた統合ソフトウェア開発キットです。互換性の取れた環境で高性能なAI推論や開発が可能になり、個別インストールによる不整合リスクを防ぐことができます。

sudo apt update

sudo apt install nvidia-jetpackまた、以下のようなコマンドで特定のコンポーネントだけ導入することも可能です。

sudo apt install <コンポーネント名>

# (例)CUDA開発ツール

sudo apt update

sudo apt install nvidia-cuda-dev

JetPack SDKセットアップと詳細な構成要素はこちらに記載があります(JetPack SDK Setup — Jetson AGX Thor Developer Kit – User Guide)

5章. AI推論の動作確認

ここからは、前章まででセットアップしたJetson AGX Thor 開発者キットの環境を用いて、実際にAI推論を試していきます。

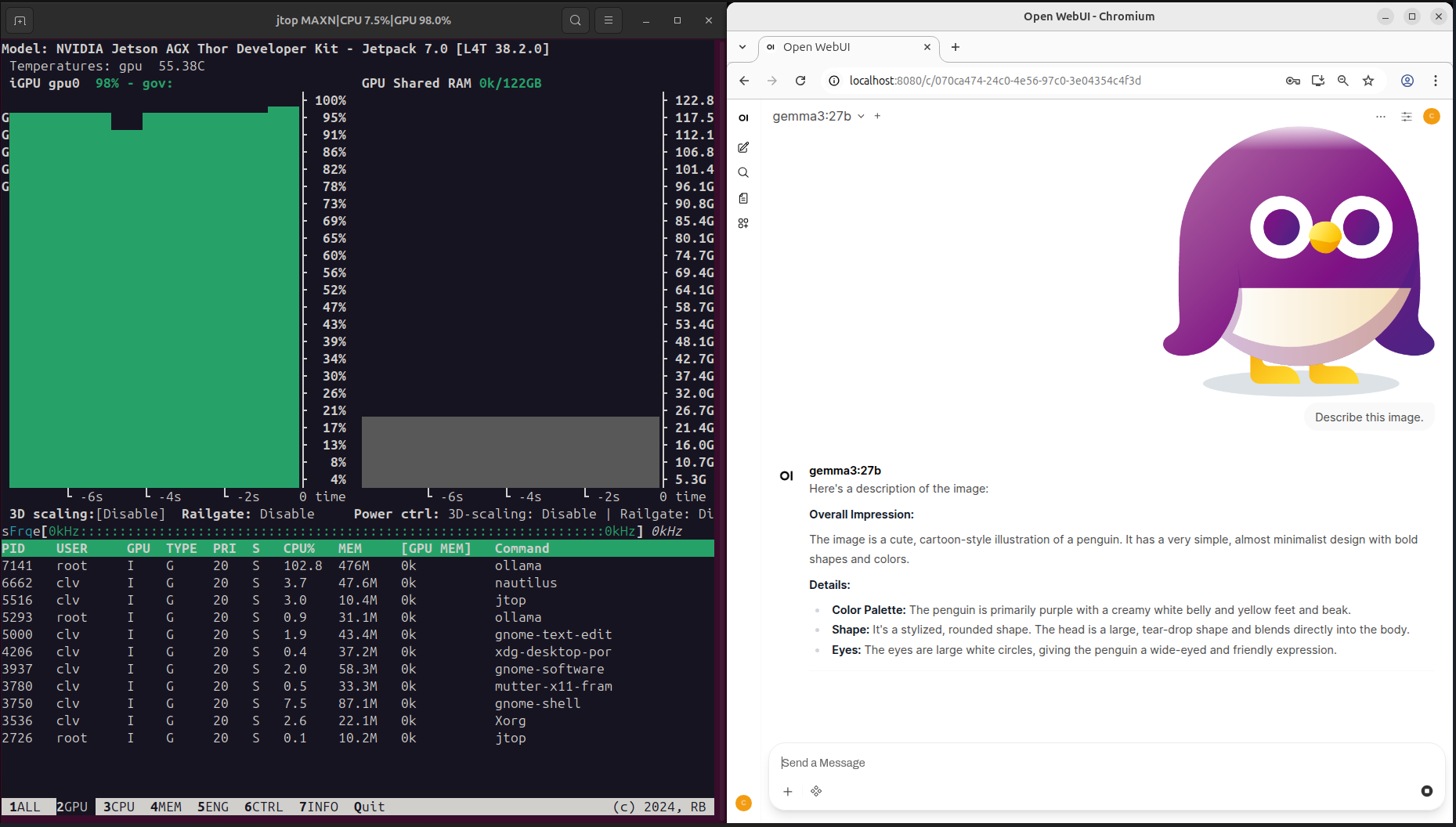

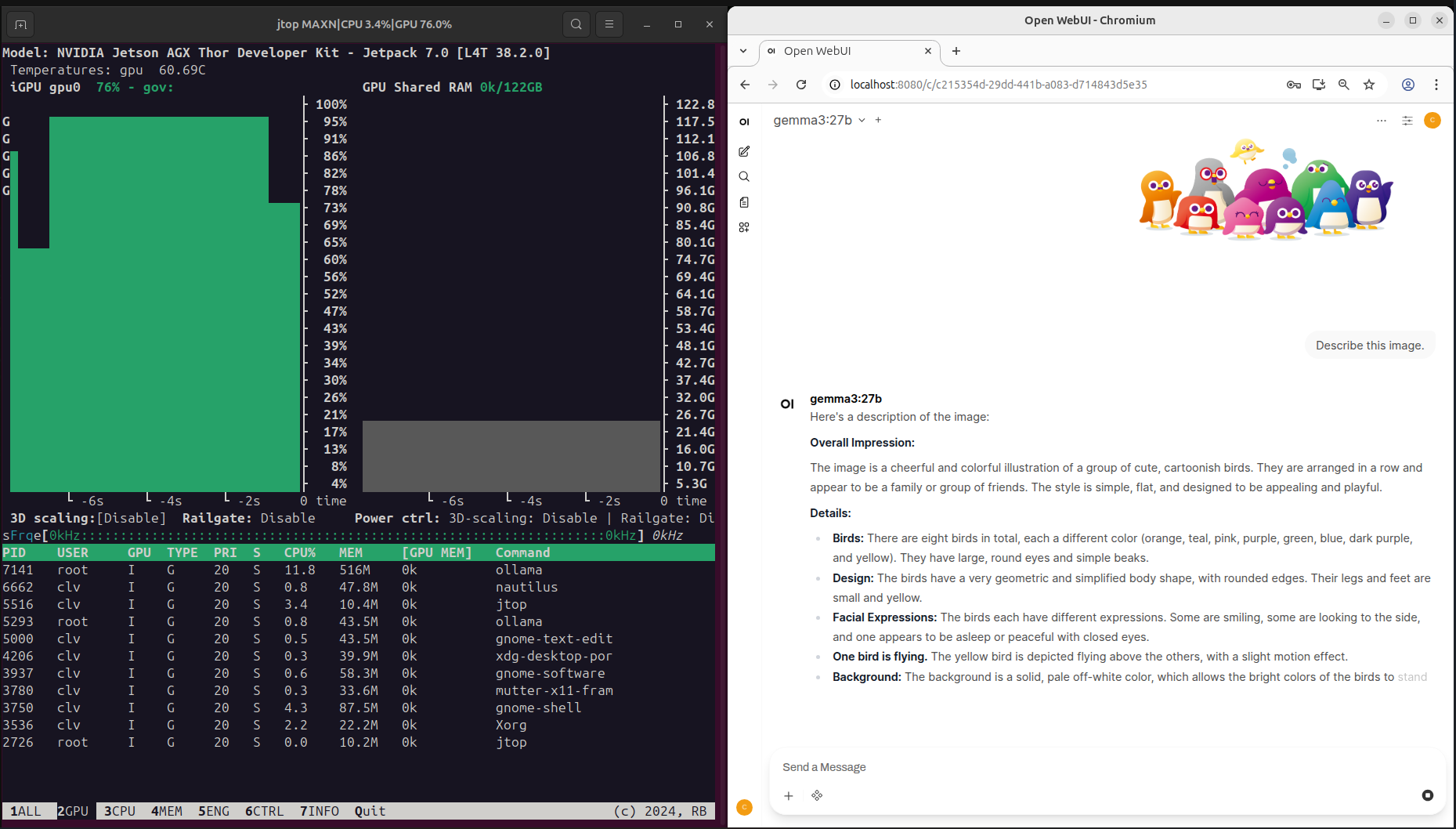

この章では、 Jetson AI Lab(Home – NVIDIA Jetson AI Lab)を参考に、Ollama × Open WebUIで2種類のモデルを動かしていきます。

動かすモデル

- gpt-oss:120b … OpenAIが公開した多言語対応のオープンソースAIで、高精度な文章生成や推論が可能

- Gemma3:27b … Googleが公開したAIで、文章だけでなく画像も扱えるモデル

前提条件

- Docker + NVIDIA Container Toolkit が動作している(章4.2がクリアできていれば大丈夫です)

- Jetson AGX Thor 開発者キットがネットワークに接続されている

- Webブラウザが入っている(今回はChromiumを使用しました。デフォルトで入っていないので、アプリセンターからインストールしてください)

- システムモニタリングツールが入っている(GPUの使用率などを確認したい場合に限ります。さまざまなツールがありますが、今回はJetsonシリーズ向けの “jtop” を使用しました。執筆時点では以下の作業でインストールが可能になっています。詳細はこちらを御覧ください。(https://forums.developer.nvidia.com/t/a-method-to-install-jtop-on-thor-without-break-system-packages/344099))

- OllamaコンテナとOpen WebUIコンテナが最新のものになっている(最新情報はJetson AI Lab(https://www.jetson-ai-lab.com/)でご確認ください。)

手順

1. 上記リンク内のsh.txtとpatch_thor_jp7_in_repo.sh.txtをダウンロードする。

2. ダウンロードしたディレクトリに移動し、以下のコマンドを実行する。

sudo apt install dos2unix

dos2unix setup_Jtop_thor.sh

dos2unix patch_thor_jp7_in_repo.sh

chmod +x *.sh

sudo ./setup_Jtop_thor.sh3. 以下のコマンドでjtopが起動します。

sudo jtopOllamaコンテナを立ち上げる

初回のみ以下のコマンドを実行してください。

mkdir ~/ollama-data/続いて、以下のコマンドでOllamaコンテナを起動します。(初回のみダウンロードが入ります)

docker run --rm -it --gpus all --runtime nvidia --network=host -v ${HOME}/ollama-data:/data ghcr.io/nvidia-ai-iot/ollama:r38.2.arm64-sbsa-cu130-24.04以下のような表示が出たら成功です。

Starting ollama server

OLLAMA_HOST 0.0.0.0

OLLAMA_LOGS /data/logs/ollama.log

OLLAMA_MODELS /data/models/ollama/models

ollama server is now started, and you can run commands here like ‘ollama run gemma3’モデルをダウンロードする

続いて、Ollamaで動かすモデルをダウンロードします。

以下のコマンドでモデルのダウンロード → 実行ができます(ダウンロードは初回のみで、実行2回目以降はすぐにモデルを動かせるようになります)

ollama run <model name>Ollamaで使用するモデルとその導入方法は、Ollamaのサイトの各モデルのページで確認いただけます(Ollama Search)。

今回は、gpt-oss:120bとgemma3:27bを動かすので、以下のコマンドを実行します。(それぞれ別ターミナルで実行)

ollama run gpt-oss:120b

ollama run gemma3:27bダウンロードが終わるとセッションがはじまり、以下のように表示されます。

success

>>> Send a message (/? for help)

試しに何かプロンプトを入力してみてください。LLMからの返答が出力されれば成功です。

/byeとプロンプトを入力すると、セッションから抜けることができます。

⚠️ gpt-oss:120bとgemma3:27bは同時に推論を実行しないでください。メモリーが足りなくなる恐れがあります。

⚠️ gpt-oss:120b で推論を実行した後に gemma3:27b を実行しようとすると、メモリー不足により処理が開始できない場合があります。

(gemma3:27b で推論を実行した後に gpt-oss:120b で推論を実行する場合も同様です)

この事象は、前回使用したモデルに関連する情報がメインメモリーおよびファイルシステムキャッシュに残留することに起因します。

この場合、システムを再起動することで解消できます。

なお、Open WebUI コンテナを併用している場合も、再起動により同様に解消されます。

再起動を行うと、--rm オプションによりコンテナは停止・削除されます。再起動後は、必要に応じて再度コンテナ起動コマンドを実行してください。

Open WebUIコンテナを立ち上げる

まず、Ollamaサーバーが起動しているか確認します。

curl -v http://127.0.0.1:11434/api/version出力の中に、 Connected to 127.0.0.1(127.0.0.1) port 11434 があれば成功です。

続いて、以下のコマンドでOpen WebUIコンテナを起動します。(初回のみダウンロードが入ります)

docker run --network=host --rm -v ${HOME}/open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui ghcr.io/open-webui/open-webui:main少し時間が経ったら、Webブラウザで https://localhost:8080 にアクセスします。(Started server processが見えたらアクセス可能になります)

“Get Started” をクリックし、ダミーのユーザー情報を入力すると、ChatGPTのようなUIが表示されます。

ここから、Ollamaにダウンロード済みのモデル(例:gemma3, gpt-oss:120b)を選択してチャットができるようになります。

実際に推論する

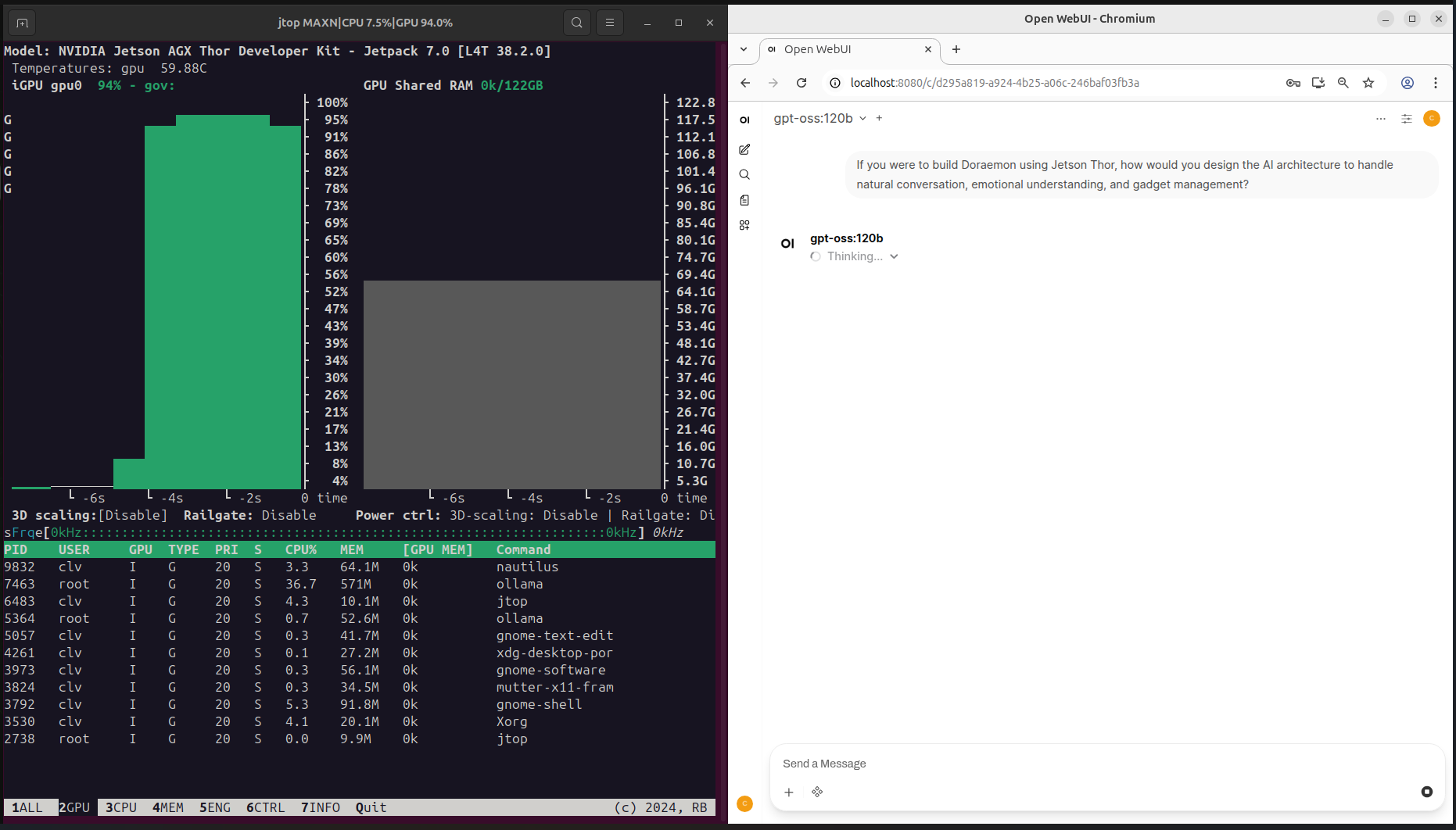

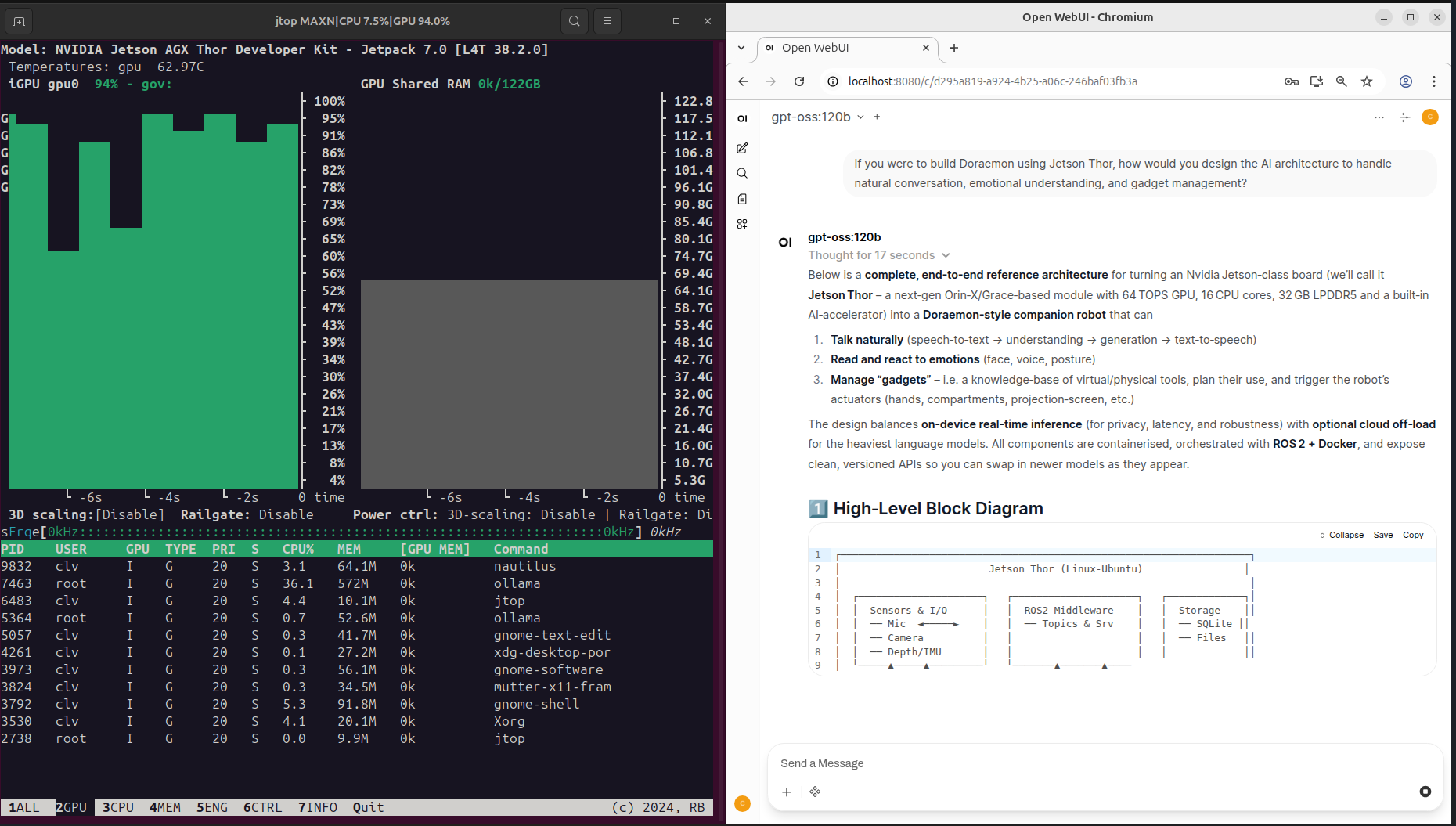

まずは、gpt-oss:120bを動かしてみます。

ロボティクス向けのJetson AGX Thorにちなんで、こんなことを聞いてみました。

“If you were to build Doraemon using Jetson Thor, how would you design the AI architecture to handle natural conversation, emotional understanding, and gadget management?”

日本語訳: 「もしJetson Thorでドラえもんを構築するとしたら、自然な会話、感情理解、ガジェット管理を処理するAIアーキテクチャーをどのように設計しますか?」

そうすると、以下の画像のように回答を生成し始めました。

GPUを使って推論している様子も見て取れます。

続いて、gemma3:27bを動かします。

マクニカのマスコットキャラクターである「タネペン」の画像をアップロードして、画像について説明してもらいました。

これらは、Dockerコンテナの中でCUDAを用いてAIが推論したということを示しています。

【チュートリアル作成にあたって参考にしたサイト】

Ollama → Ollama - NVIDIA Jetson AI Lab

Open WebUI → Open WebUI - NVIDIA Jetson AI Lab

6章. 終わりに

本記事がJetson AGX Thor 開発者キットのセットアップおよびAI推論の動作確認の一助となれば幸いです。

また、マクニカではJetsonに限らず、AI導入に向けて、ハードウェアのNVIDIA GPUカードやGPUワークステーションの選定やサポート、また顔認証、導線分析、骨格検知のアルゴリズム、さらに学習環境構築サービスなどを取り揃えています。本記事下部のリンク集を参考にしていただけると幸いです。

お困りの際は、本記事下部の問い合わせボタンより、ぜひお問い合わせください。

7章. Appendix(インストール手順:SDKマネージャー&フラッシュスクリプト)

SDKマネージャー

⚠️こちらのWebサイトにあるように(SDK Manager | NVIDIA Developer)、Jetson AGX Thor対応のJetPack 7.x以降をSDKマネージャー経由でセットアップするためには、Ubuntu 22.04か24.04が必要です(執筆時点での情報のため、必ず最新情報を確認してください)。

⚠️ダウンロードには、ホストUbuntu PCに数十GB規模の空き容量が必要となります。事前に必ず容量に余裕があるかチェックしてください。(必要な容量の目安はGUI下部に表示されます)

⚠️SDKマネージャー使用時にNVIDIA Developerへログインします。アカウントをお持ちでない場合は、新規作成をしてください。

詳細な手順はこちらのWebサイトに記載があります(Install Jetson Software with SDK Manager — SDK Manager)。

1. ホストUbuntu PCにSDKマネージャーをダウンロードします。([distro]部分は、ubuntu2204 や ubuntu2404が入ります。ご自身のホストUbuntu PCのバージョンを選択してください。)

wget https://developer.download.nvidia.com/compute/cuda/repos/[distro]/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install sdkmanager2. ダウンロード完了後、ターミナルで以下のように実行するとSDKマネージャーが起動します。

sdkmanager3. 画面の指示に従ってNVIDIA Developerへログインします。こちらのWebサイトを参照しながら進めてください(Download and Run SDK Manager — SDK Manager)。

4. Jetson AGX Thor 開発者キットとホストUbuntu PCを接続し、Jetson AGX Thor 開発者キットをフォースリカバリーモードにして起動します。

フォースリカバリーモードでの起動が成功すると、SDKマネージャー側がJetson AGX Thor 開発者キットを認識した旨の表示がされます。

以下、Jetson AGX Thor 開発者キットのフォースリカバリーモード起動方法です。

- Jetson AGX Thor 開発者キット側面のUSB-Cポート(蓋の中のデバッグ用USB-Cポートではない)とホストUbuntu PCを繋げる

- 中央のフォースリカバリーボタンを押しながら電源コネクタを接続。電源が入って数秒経ったらフォースリカバリーボタンを離す。

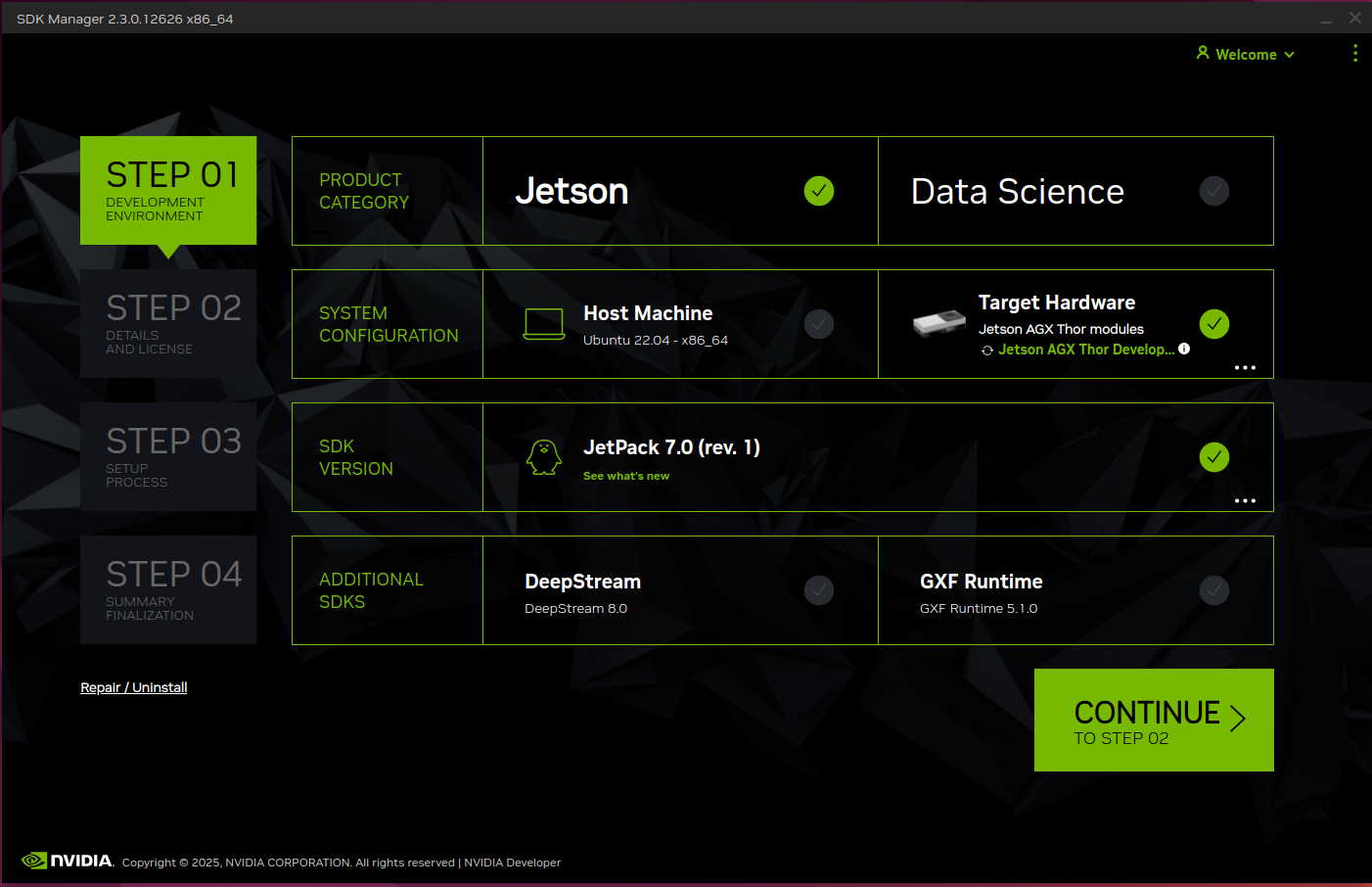

5. STEP01:以下の画像のようにチェックマークを入れ、“CONTINUE” をクリックします。(適宜ADDITIONAL SDKSを選択してください)

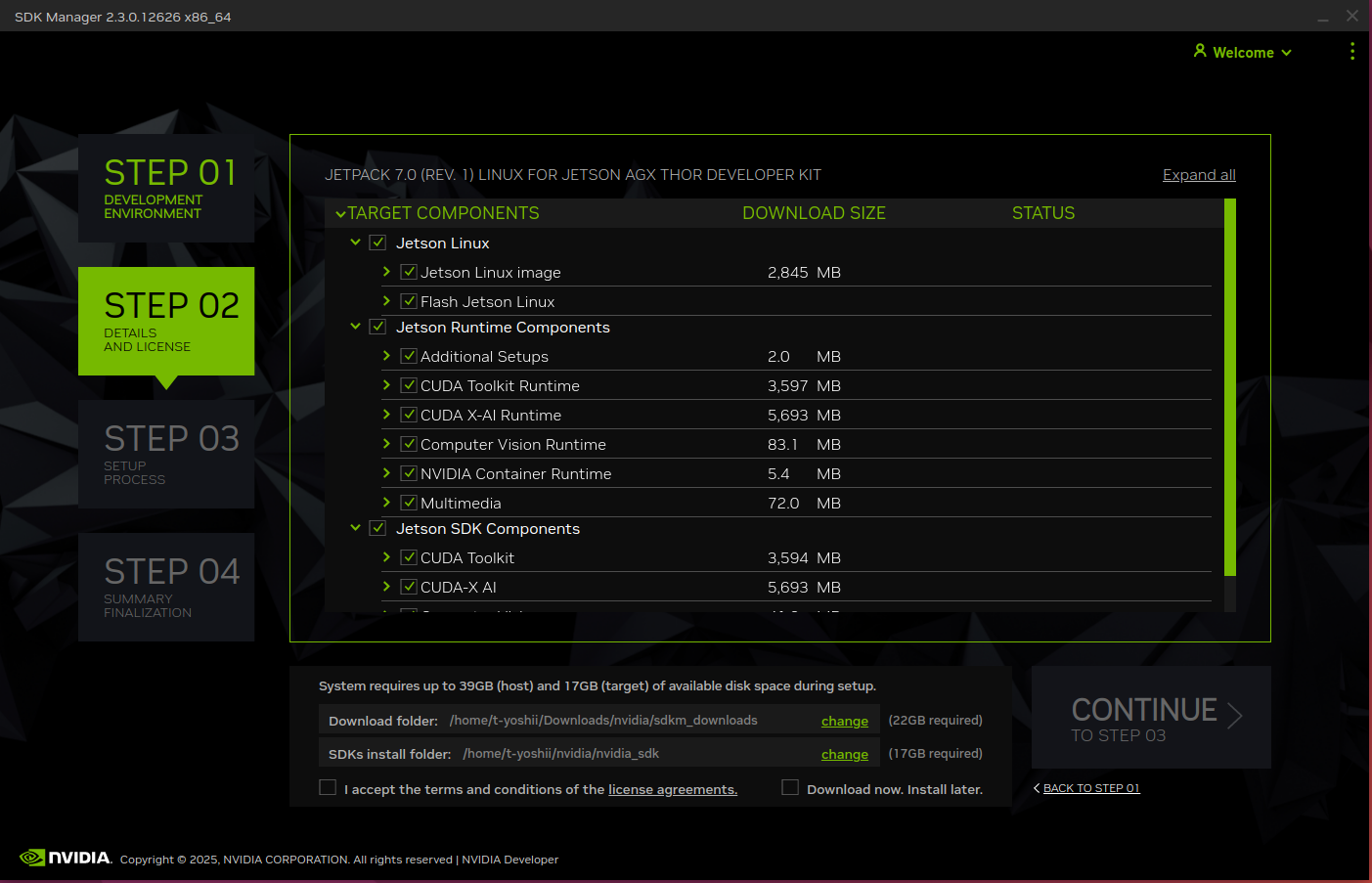

6. STEP02:Jetson Linuxとインストールしたいコンポーネントにチェックを入れます。

その後 “I accept the terms and conditions of the license agreements” にチェックを入れて “CONTINUE” をクリックすると、インストールが開始されます。

⚠️ホストUbuntu PCにデータをダウンロードする場所はGUI下部で変更可能です。

7. インストールの途中で、これからJetson AGX Thor 開発者キットで使うユーザーネームとパスワードの入力を求められるので、入力をして先に進みます。

8. しばらくするとインストールが終了します。Jetson AGX Thor 開発者キットの電源ボタンを長押しして電源をオフにし、ディスプレイ・キーボード・マウスに繋げて電源を入れると、

Ubuntuのセットアップが始まります。以降は画面の指示に従ってセットアップを完了してください。

9. セットアップ後、1度再起動をしてください。

10. 以上でセットアップは完了となります。

SDKマネージャー経由でのインストールにおける注意点

インストールに失敗した際は、こちらのWebサイト内(Install Jetson Software with SDK Manager — SDK Manager)の “Recommended Recovery Steps” を参照の上、

リカバリーを実行してください。

フラッシュスクリプト

⚠️Jetson AGX Thorに対応しているJetpackは、JetPack 7.x以降です。

⚠️ホストUbuntu PCに数十GB規模の空き容量が必要となります。事前に必ず容量に余裕があるかチェックしてください。(必要な容量の目安はGUI下部に表示されます)

詳細な手順はこちらのWebサイトに記載がありますので、こちらを参照しながら進めてください(Quick Start — NVIDIA Jetson Linux Developer Guide)。

1. Jetson Linux Archive(Jetson Linux Archive | NVIDIA Developer)からインストールしたいJetson Linuxのページに移動する。

2. Jetson Linuxのページ内の、“Driver Package (BSP)” と “Sample Root Filesystem” をクリックしてダウンロードする。

3. 以下のコマンドを順番に実行します。

tar xf < Driver Package (BSP)でダウンロードされたファイル名>

sudo tar xpf < Sample Root Filesystemでダウンロードされたファイル名> -C Linux_for_Tegra/rootfs/

cd Linux_for_Tegra/

sudo ./tools/l4t_flash_prerequisites.sh

sudo ./apply_binaries.sh –openrm

4. Jetson AGX Thor 開発者キットとホストUbuntu PCと接続し、Jetson AGX Thor 開発者キットをフォースリカバリーモードにして起動します。

フォースリカバリーモードの手順に関しては、上記 「SDKマネージャー」 内の文章を参照ください。

フォースリカバリーモードでの起動が成功すると、 lsusb コマンドで表示される複数のデバイスの中に、以下のような表示が出ます。

Bus 001 Device 021: ID 0955:7026 NVIDIA Corp. APX“7026” はJetson AGX Thor 開発者キットあることを示しています。

5. Jetson AGX Thor 開発者キットがフォースリカバリーモードで認識されていることを確認できたら、以下のコマンドを実行します。インストールが始まります。

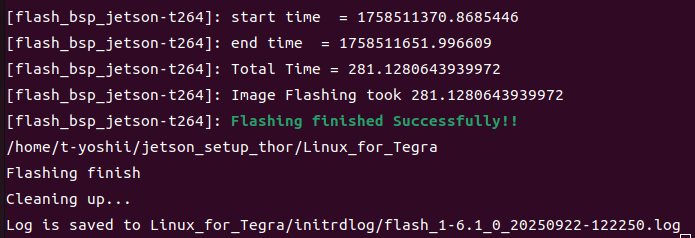

sudo ./l4t_initrd_flash.sh jetson-agx-thor-devkit internal6. しばらくすると以下の図のような表示がされ、インストールが終了します(同時にインストールのログもホストUbuntu PCに保存されます)。

Jetson AGX Thor 開発者キットの電源ボタンを長押しして電源をオフにし、ディスプレイ・キーボード・マウスに繋げて電源を入れると、Ubuntuのセットアップが始まります。

以降は画面の指示に従ってセットアップを完了してください。

7. Ubuntuセットアップ完了後、1度再起動をしてください。

8. 以上でセットアップは完了となります。

フラッシュスクリプトでのインストールにおける注意点

必ず、Jetson AGX Thor 開発者キットがフォースリカバリーモードで認識されていることをホストUbuntu PCで確認の上、インストールを進めてください。

7章:Appendixについてもこちらで以上となります。

長い記事となりましたが、ここまでご覧いただきありがとうございました。