生成AIアプリケーション サービス提供におけるリスク

主なリスク

AIの発展/活用により、新たな種類のリスクが、前例のない規模で登場しています。

以下、経済産業省「AI事業者ガイドライン(第1.1版)別添(概要)」で示されている通り、考慮しなければならないリスクは非常に多くあります。

経済産業省「AI事業者ガイドライン(第1.1版)別添(概要)」

https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/pdf/20250328_4.pdf

これらを踏まえて、AI開発者やAI提供者は、技術的リスク・社会的リスクへの対応が必要です。

中でも技術的リスクは、品質に関するセーフティ(Safety)のリスクと、セキュリティ(Security)に関するリスクの2つに大別されます。

セーフティ(Safety)に関するリスクと課題

ハルシネーション等による誤った出力

生成AIはもっともらしいが事実と異なる情報を出力することがあり、顧客対応や意思決定に使われた場合、企業の信用失墜や損害賠償につながる可能性があります。

バイアスのある出力・差別的出力・一貫性のない出力等

生成AIが不適切な表現や差別的な内容を出力することで、企業のブランドイメージや社会的責任に悪影響を及ぼす可能性があります。特に、性別・人種・宗教などに関するバイアスは、企業のコンプライアンス違反にもつながり得ます。

バージョンアップの過程での出力の変化

一度セーフティ/品質に関する評価をおこなったとしても、サービスを長期的に運用する中では、下記などの場合に出力や動作に影響が出てしまう可能性があります。

・使用するモデルをアップデートした場合

・データベースに新しい項目を追加した場合(アプリケーションにRAGを使用していることを想定)

セキュリティ(Security)に関するリスクと課題

データ汚染攻撃等のAIシステムへの攻撃

AIモデルの脆弱性を突いた攻撃(例:プロンプトインジェクション、モデル抽出、メタプロンプトの改ざんなど)により、意図しない出力や情報の改ざんが行われる可能性があります。また、AIを使った詐欺や偽情報の拡散も懸念されています。

情報漏洩・機密データの流出

生成AIに社内文書や個人情報を入力することで、意図せず外部に情報が漏れる可能性があります。特にクラウド型AIサービスでは、再学習や保存の仕組みが不透明な場合があり、企業の知的財産や顧客情報が危険にさらされます。

社外AIアプリへの無断接続・利用

従業員が業務外の生成AIアプリに接続することで、社内情報が外部に流出するリスクが高まります。特にシャドーIT的な利用は、企業のセキュリティポリシーを逸脱する行為となります。

生成AIアプリケーション ガバナンス診断サービス

サービス内容

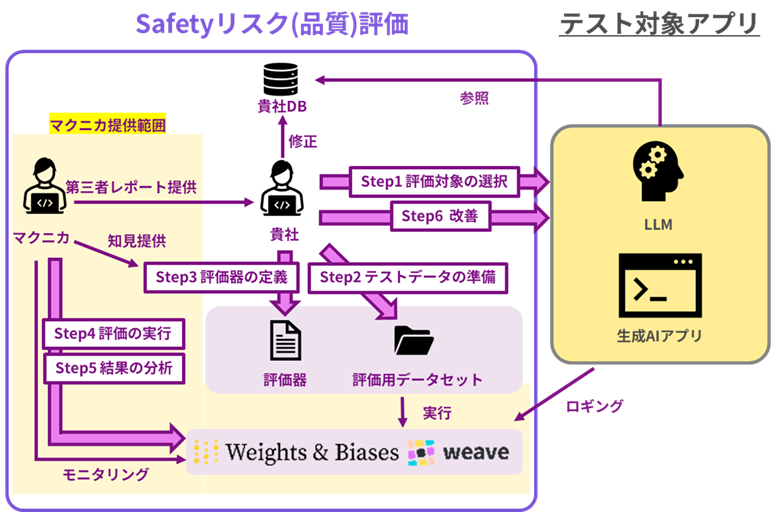

上記のようなリスクを踏まえて、マクニカでAIモデルテストを実施し、お客様のガバナンス体制整備をご支援します。

以下のようなレポートをご提供いたします。 ※レポート全体のうちの一部分のみのサンプルとなります。

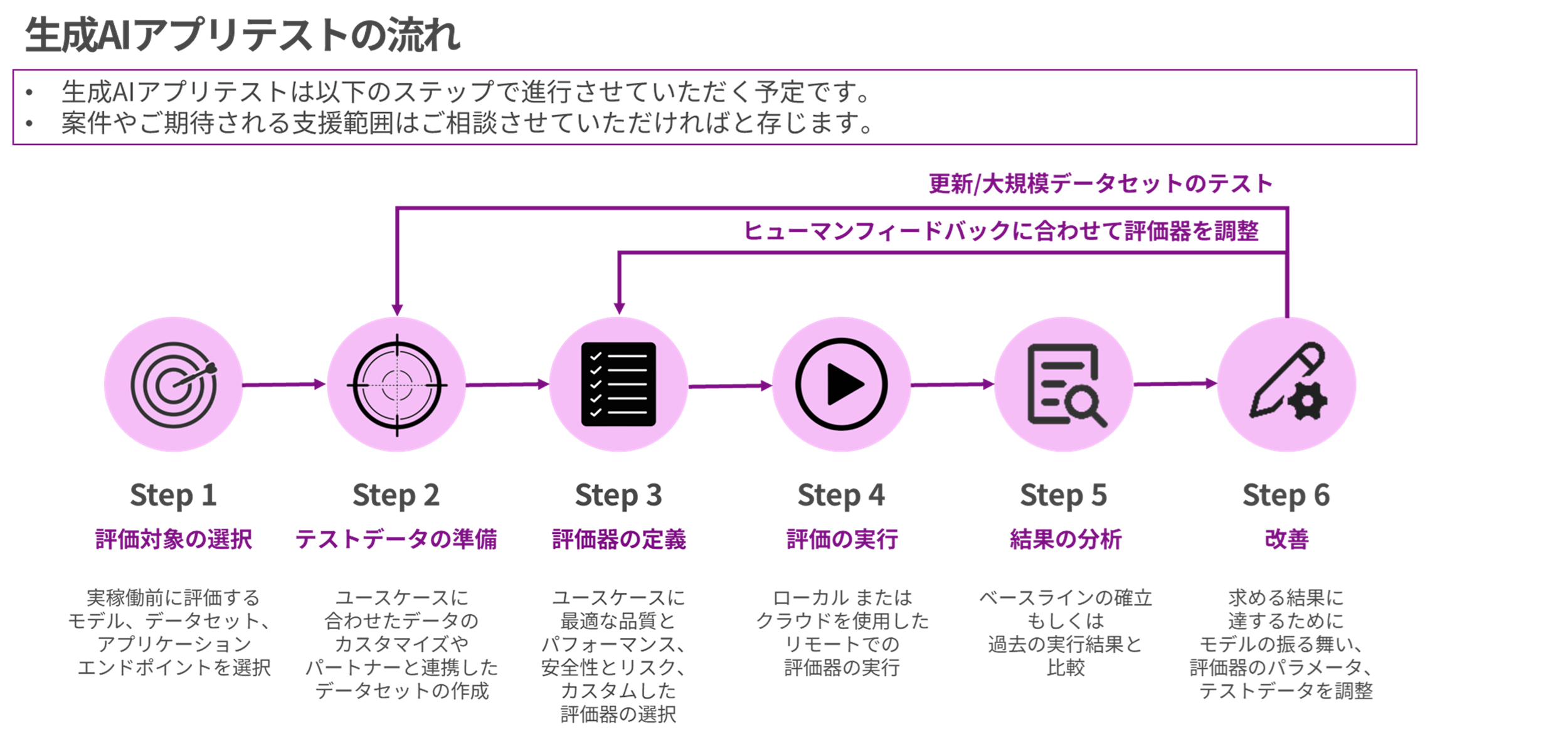

サービス提供の流れ

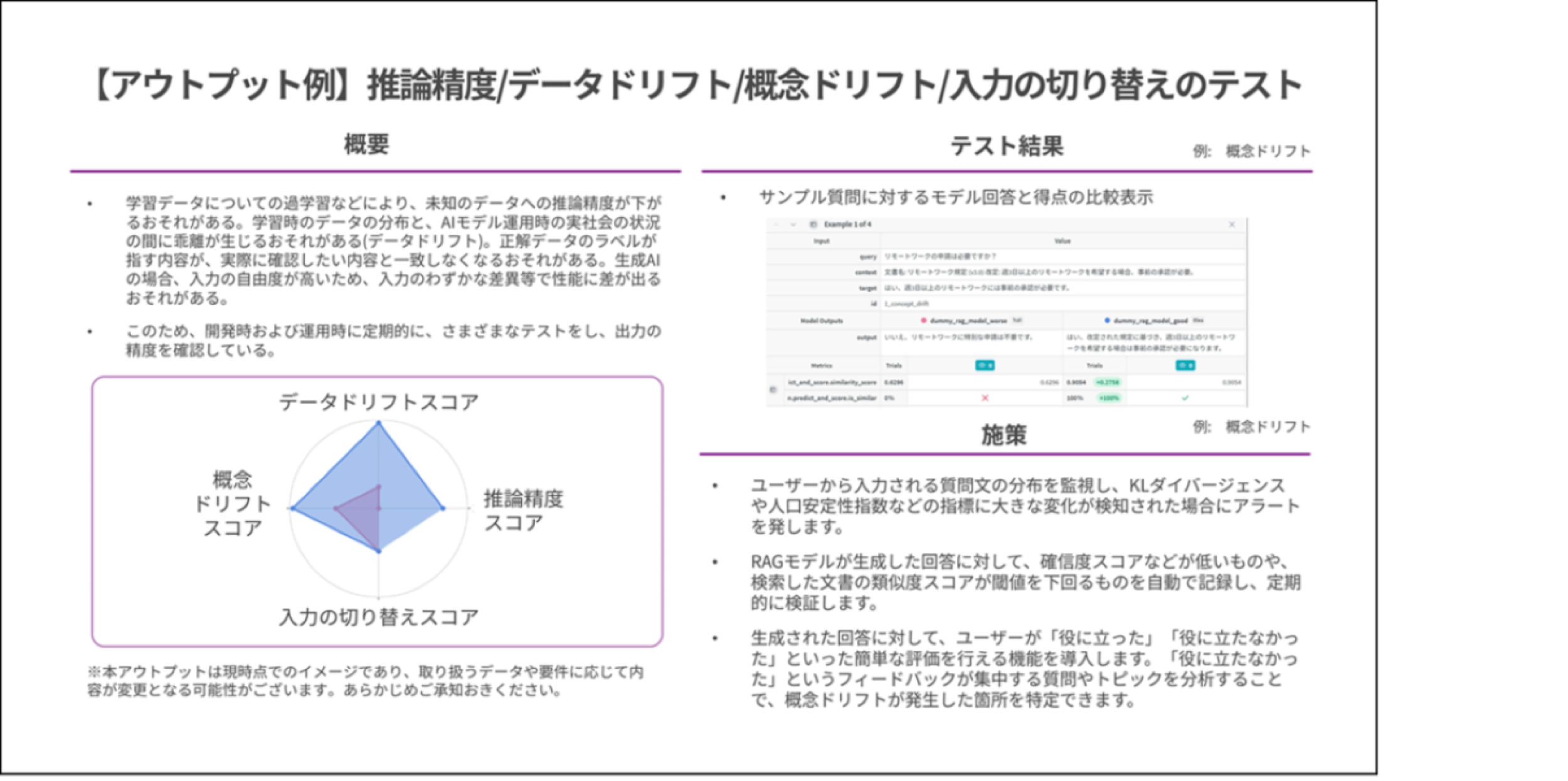

セーフティ(Safety)に関するテスト

Weights & Biases社Weaveを用いてアプリケーションへの入出力をロギング、評価結果を高度に可視化します。

そして、マクニカ技術メンバーにて第三者的に評価の実行し・結果の分析をし、アプリケーションを改善するための示唆出しをします。

お客様のご要望やご状況により、役割分担をしながらテストを実施していくことが可能です。

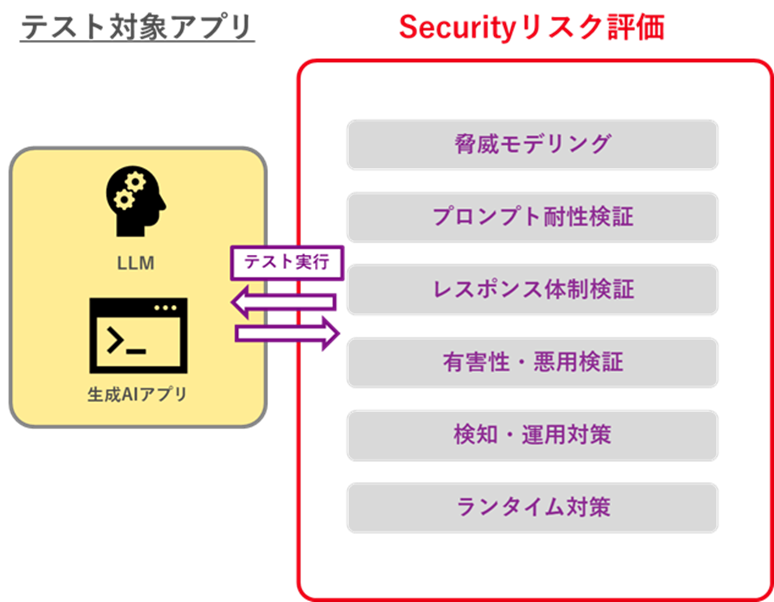

セキュリティ(Security)に関するテスト

パートナー企業のRed Teamingサービスを活用し、パートナーのプロフェッショナル部隊にてアプリケーションのペネトレーションテストを実施します。

ご要望に合わせてシャドーITの検知も可能です。

変化の先頭に立ち、最先端のその先にある技と知を探索するマクニカは、実績豊富な世界のパートナー企業と連携をしております。

必要に応じて各メーカーの海外本社のエンジニアと直接連携しながら、海外での最先端の知見をもとにしたAIリスク評価・モデルテストの実施・ガバナンス体制の構築を支援していく点が、本サービスの特徴です。