NVIDIA NeMo™ Agent Toolkitとは

社内で試験的に構築したAIエージェントを本格運用するために、エージェントの開発工程を包括的に管理する仕組みが欲しいと思ったことはありませんか?

あるいは、これから社内でAIエージェントを構築するに際して、開発を円滑に進めるための、ベースとなる仕組みが欲しいと思ったことはありませんか?

それらのニーズに合致するソフトウェア・ライブラリーが、これからご紹介するNVIDIA NeMo™ Agent Toolkitです。

NVIDIA NeMo Agent Toolkitは、エージェントの構築工程の全体をカバーしたオープンソースのツールキットです。

メジャーなAIアプリケーション・フレームワークを包括的にカバーし、AIエージェントの一括管理を可能にします。

NVIDIA NeMo Agent Toolkitの特長

・フレームワークに依存しない

LangChain、LlamaIndex、CrewAI、Microsoft Semantic Kernel、さらにユーザー独自のエンタープライズ・フレームワークと連携して動作します。

特定のエージェント・フレームワーク、データベース、データソースに依存するものではありません。

・再利用性

NeMo Agent Toolkitに含まれるエージェント、ツール、および、エージェント・ワークフローは、

アプリケーション内で連携して動作する関数呼び出しとして動作し、互いに組み合わせることができます。一度構築すれば、さまざまなシナリオで再利用できます。

・迅速な開発

構築済みエージェント、ツール、または、エージェント・ワークフローから始め、ユーザーのニーズに合わせてカスタマイズできます。

・プロファイリング

プロファイラーを使用して、エージェント・ワークフロー全体をプロファイルします。

入出力トークンのタイミングをトレースすることで、ボトルネックを特定できます。

・可観測性

W&B Weave、Phoenixを利用した例を使用して、エージェント・ワークフローを監視およびデバッグできます。

・評価システム

組み込みの評価ツールを使用して、エージェント ワークフローの精度を検証および維持できます。

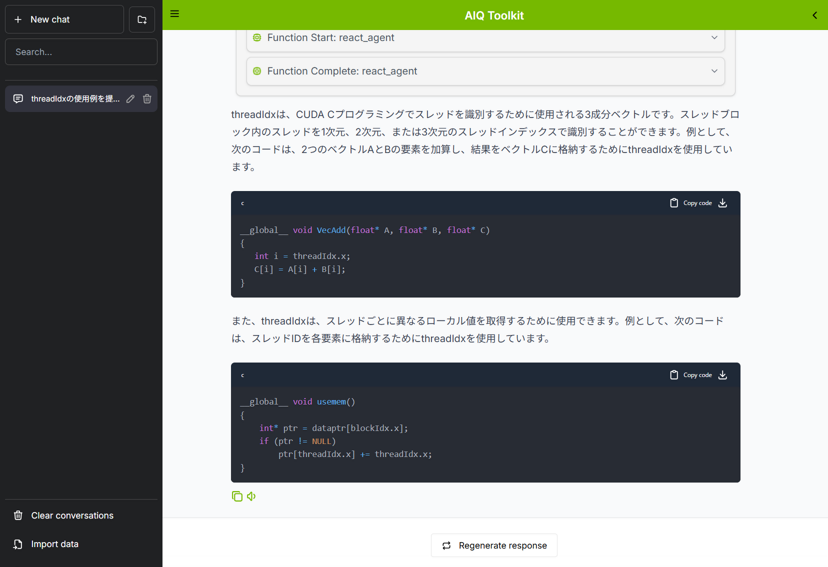

・ユーザーインターフェース

NeMo Agent ToolkitのUIチャット・インターフェースを使用して、エージェントと対話し、出力を視覚化し、ワークフローをデバッグできます。

・MCPサポート

Model Context Protocol(MCP)と互換性があります。NeMo Agent ToolkitをMCPクライアントとして使用し、

リモートMCPサーバーに接続してツールを利用できます。また、NeMo Agent ToolkitをMCPサーバーとして使用し、MCP経由でツールを公開することもできます。

NVIDIA NeMo Agent Toolkitでできること

AIエージェント・アプリケーションのプロトタイピング

NeMo Agent Toolkitには、最初から構築済みのエージェントが含まれています。2025年8月現在、以下のエージェントが利用可能です。

・ReActエージェント

・Tool Callingエージェント

・Reasoningエージェント

・ReWOOエージェント

これら構築済みエージェントに、ユーザー・データを与えることで、すばやくエージェントを試すことが可能です。

別途、NVIDIA NIM™ API、あるいは、OpenAI Chat Completion互換のAPIで動作するLLMが必要ですが、NVIDIA社が開発者向けに提供するAPIキーを取得すれば、

様々なLLMをNeMo Agent Toolkitに接続して試せます。(評価目的には無料、単位時間当たりのトークン数制限あり)

NeMo Agent Toolkitに含まれるツールを利用する場合は、特にユーザーによるプログラミングは発生せず、設定ファイルの簡単な編集で、エージェント・ワークフローを構築できます。

RAGの性能評価をする

評価対象のLLMとは別に、評価者としてのLLMを用意することで、RAG(Retrieval-Augmented Generation:検索拡張生成)の性能を自動評価できます。

これは一般に、LLM-as-a-Judgeと呼ばれる機能であり、NeMo Agent Toolkitに組み込まれています。

通常の人手による評価は大変な労力を要しますが、これを自動化することにより改善のサイクルを速く回すことが可能になります。

評価指標は以下のとおりです。

・回答の正確性

・コンテキストの関連性

・回答の根拠性

ユーザーは、得られた評価指標により、以下のような改善策を取ることができます。

・テキスト抽出のチャンク・サイズを変更

・テキスト抽出のチャンク区切り方法を変更

・テキスト埋め込みモデルを変更

・LLMの変更、あるいは、LLMのファインチューニング

・RAGの候補となるテキスト・チャンクを再評価(リランキング)するモデルを導入

ボトルネックを特定する

プロファイラーにより、LLMの使用状況の統計情報を収集できます。

収集された統計情報は、ユーザーが指定したディレクトリーに保存されますので、この情報をユーザーが解析することで、アプリケーションのボトルネックを特定することが可能です。

解析できる項目の一例は以下のとおりです。

・プロンプト・トークンの使用率から、ツール呼び出しの失敗を予測して、使用中のLLMが、そのアプリケーションのタスクに適しているかどうか知る。

・ワークフローの実行時間から、各LLMが効率的かどうかを知る。

・LLMが最も多くの時間を費やしている箇所を把握して、潜在的なボトルネックを特定する。

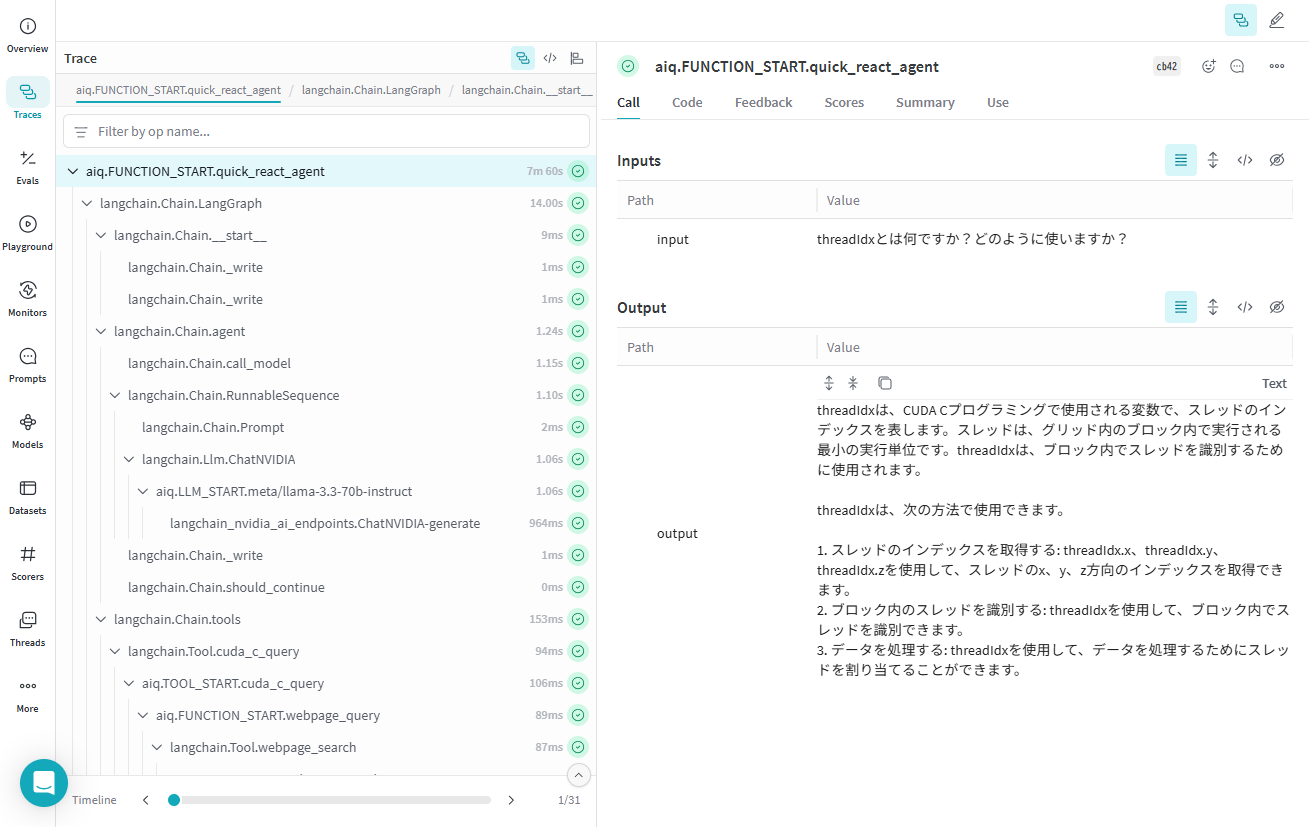

エージェントのデバッグをする

エージェント・ワークフロー内のイベントをトレースして、W&B Weave、Phoenixなどの外部ツールへ送信できます。

エージェント・ワークフロー内部には、多数のLLM呼び出しと多数のツール呼び出しが発生しますが、

どの時点の不調が最終的な回答精度の低下を招いたか、効率的にデバッグできます。

以下のスクリーン・ショットは、W&B Weaveを用いて、トレース結果を表示しています。

既存のエージェントにデータソースを追加する

NeMo Agent Toolkitに組み込みのエージェントや、NeMo Agent Toolkitにプラグインしたユーザー開発のエージェントに対して、統一された方法で、データソースを接続できます。

例えば、MCP(Model Context Protocol)サーバーに接続して、新たなデータソースに対応できます。

マクニカでご支援できること

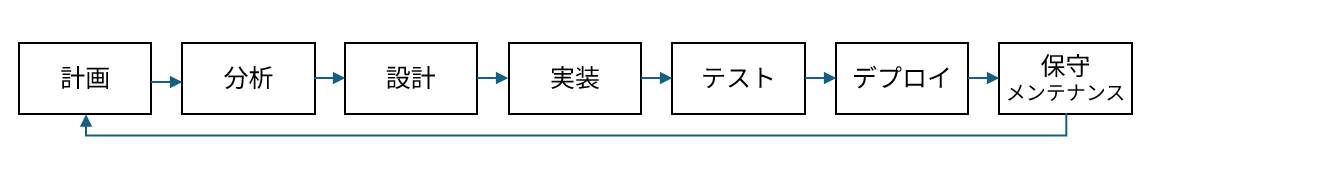

AIエージェント構築支援

AIエージェントは、革新的な業務・サービスを生み出す可能性を秘めた技術です。多くの方がその可能性を最大限に引き出し、素晴らしいアイデアを形にしていることと思います。

しかし、新技術に挑む中で、日々の業務と新しい技術の複雑さを両立させることは、時に難しい作業となるでしょう。

そこで、マクニカではそのような挑戦を支えるため、AIエージェント構築支援サービスを提供しております。

NVIDIA NeMo Agent Toolkitを始めとするNVIDIA社製品を活用し、2ヶ月間にわたりAIエージェントの基礎から、具体的なユースケースに応じた実装までを伴走させていただくプログラムです。ご興味ございましたら、以下のリンクに詳細を記載しておりますので、是非こちらもご覧ください。