こんな方におすすめの記事です

- 手っ取り早く最新AI論文のトレンドを押さえたい!

- 話題となったAI論文について知りたい!

- 話題となったDeep Image Priorとはどんな手法なのか簡単に知りたい!

この記事を読み終えるのに必要な時間

5分

画像処理に有用な手法をご紹介

こんにちは、マクニカAI女子部のMakkyです!

あっという間に2019年の半分が終わってしまいました…。一日一日充実しているからこそ時間の経過が速く感じるのですが、もう少し一日が長ければ良いのに…と思わざるを得ないこの頃です。

さて、前回のAI女子部テックブログではD-GraphCNNという、CNNを画像以外のデータに応用する最新手法を取り上げました。

今回は昨年発表された論文の中から、界隈を賑わせた「Deep Image Prior」というニューラルネットワーク構造を利用した画像復元手法をご紹介いたします。

画像処理に有用なディープラーニング手法:CNN

前回のブログでもお伝えしたように、CNNはディープラーニングの中でも画像に有用な手法です。そもそもCNNが注目され始めたのは、2012年。

ディープラーニングを勉強している人なら聞いたことのある話ではありますが、2012年の画像認識コンテスト「ILSVRC(ImageNet Large Scale Visual Recognition Challenge)」で、トロント大学のチーム”SuperVision”が圧倒的に良い記録で優勝したことが始まりです。

”SuperVision”が使用した手法がCNNであり、この大会以来、CNNはさまざまな画像処理タスクで使用されてきました。

教師データを必要としない Deep Image Prior

通常CNNなどディープラーニングを利用した分析では大量の教師データを用意し、その教師データを元にして生成されたディープニューラルネットワーク(DNN)から画像処理を行います。

しかし「Deep Image Prior」では、劣化した画像から元の画像を復元するような事象(以降、このような事象を画像復元と表記します)に対し、劣化した画像のみで問題を解決できることを示したのです。

つまり、これまで当たり前と考えられてきた事前にトレーニングされたDNNや大きな画像データセットは必要ではないと言うのです。

画像復元の一般的手法

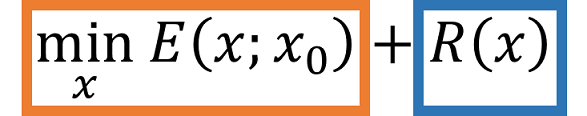

一般的に画像復元の分野では2つの最適化目標があり、以下のように定式化されます。

Retrieved from “ Deep Image Prior ” Main idea

オレンジ色で示す項目は、ノイズ除去・超解像・修復といった復元タスクに依存するデータを表します。そして青色で示す項目は、教師データから学習された画像データ「Image Prior」を表します。

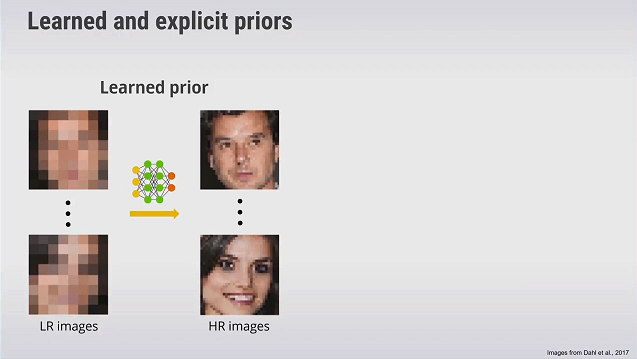

例えば、以下の図(左側)に示すようなぼやけた画像から綺麗な画像(右側)を復元する場合を考えてみましょう。

私たちの過去の経験や世界に転がる知見を生かすことで、ノイズ除去や超解像といったタスクを行わなくても綺麗な画像を復元することができるかもしれません。

このように復元をサポートするような私たちの経験、つまり”事前学習”を論文では「Prior」と呼んでいます。

斬新な Deep Image Prior の学習手法

Deep Image Priorが話題となったのは、CNN構造と復元したい画像の2つを準備するだけという斬新な点によります。

教師データが存在しないので、論文ではCNN自体をPriorとして学習に利用することを提案しています。

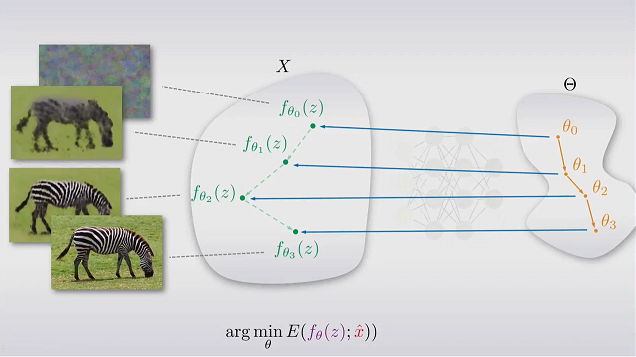

そのため画像空間から事前分布(教師データから学習した画像表現)を求めるのではなく、1つの入力画像を学習しCNNのパラメータΘを勾配降下法で最適化することで、再構成した画像を取得します。

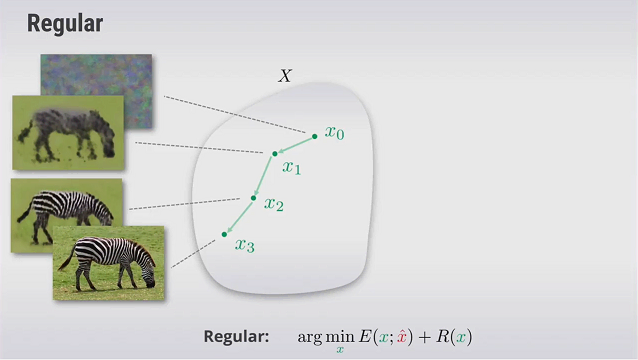

通常の画像復元(画像空間の探索)

事前トレーニングデータを用いた再構築出典: “ Dmitry Ulyanov - Deep Image Prior,” YouTube video, 1:01:40, “Man AHL,” June 5, 2018,

https://www.youtube.com/watch?v=-g1NsTuP1_I&feature=youtu.be&t=975

Deep Image Priorの画像復元(CNNのパラメータ空間の探索)

勾配降下法を用いたネットワークパラメータΘ の最適化による再構築出典: “ Dmitry Ulyanov - Deep Image Prior,” YouTube video, 1:01:40, “Man AHL,” June 5, 2018,

https://www.youtube.com/watch?v=-g1NsTuP1_I&feature=youtu.be&t=1403

Deep Image PriorのGitHubページで、画像復元のデモを簡単に試すことができます。

(リンクは本ブログの最後にございます)

なぜネットワーク構造自体が有用なのか?

なぜネットワークを用いてターゲット画像の学習を進めるだけで画像復元ができるのでしょうか?

結果から言うとまだ明確な答えは明らかにされていません。ですが、ニューラルネットワークの学習速度が影響しているようです。

ニューラルネットワークで学習を進める場合、CNNの大きなネットワークであれば誤差を限りなく0に近づけることができます。そのため今回のケースでもネットワークの出力は、学習を進めるごとにターゲット画像に近づくと考えられます。

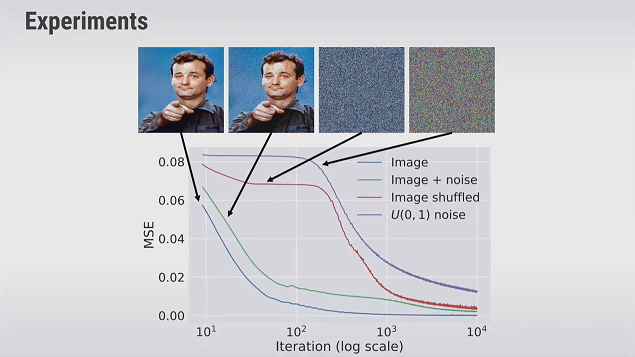

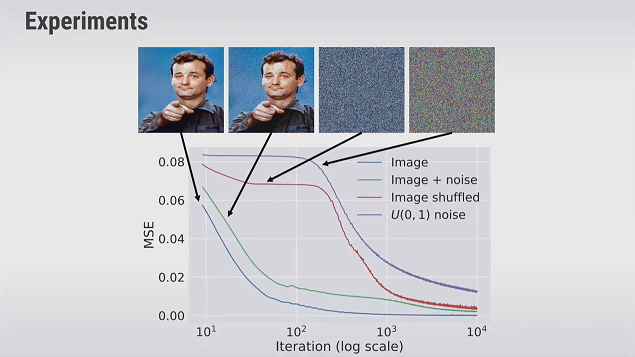

以下のグラフは、論文中にて紹介された誤差の推移を画像種別ごとに示したものです。 縦軸が誤差(平均二乗誤差:MSE)、横軸は学習の繰り返しを表します。

ニューラルネットワークの誤差の推移

出典: “ Dmitry Ulyanov - Deep Image Prior,” YouTube video, 1:01:40, “Man AHL,” June 5, 2018,

https://www.youtube.com/watch?v=-g1NsTuP1_I&feature=youtu.be&t=1715

ノイズのようなランダムな画像(noise, Image shuffled)と比べると、グラフ中の「Image」で示すような自然な画像の方が誤差を小さくする速度、つまり学習速度が速く、綺麗な画像に早く収束できることがわかります。

この学習速度の差を利用して、ノイズを学習してしまう前に学習を止めることで綺麗な画像を出力することができるようです。

この結果から、CNNには自然な画像に対するバイアスが組み込まれていると考えられ、ネットワークに学習を繰り返す時間を与えるだけで、綺麗な画像を得ることができるのでしょう。

今後もAI論文をご紹介します!

今回ご紹介した「Deep Image Prior」は CVPR 2018で発表された論文です。論文はDeep Image PriorのGitHubページから閲覧可能です。

CVPR 2019で発表されるAI論文についても、今後AI女子部のテックブログでご紹介する予定です!

今後も最新AI論文をご紹介していきますので、チェックしてみてください!

|

■ 本記事で特集したAI論文の出典元/Reference Lists |