ブレインテックとAIの融合とは

「ブレインテック×AI」とは

近年、AIが模したニューロンに紐づき、神経科学とAIの融合が注目されています。

神経科学を深層学習などITに応用することを、米国など海外では「ニューロテック」といい、広く知られています。弊社では、神経科学をAIに応用することを「ブレインテック×AI」と表しており、近年注力している分野となります。

まだ日本では発展途上の分野ではありますが、AIの可能性を広げられると期待されている「ブレインテック×AI」について、今回は研究事例をご紹介いたします。

脳波測定とAIの応用について

脳波測定について

脳波測定装置として現在主に利用されているのは、fMRI、NIRS、MEG、EEG、といった非侵襲型デバイスです。

弊社の特集記事でも紹介しておりますが、それぞれ空間分解能や時間分解能の特徴や、デバイスのサイズおよび汎用性などが異なります。

また、神経科学の分野において主に研究目的で活用されている、ウェットタイプと言われる脳波計もあります。

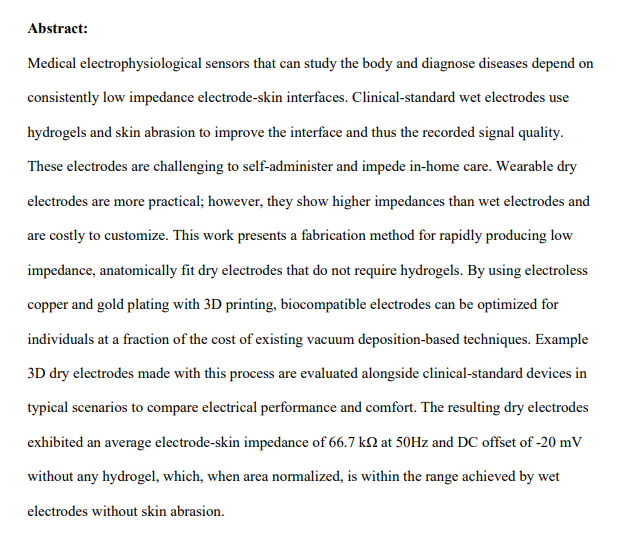

『Rapid Fabrication of Low Impedance, 3D Dry Electrodes for Physiological Sensing』にて言及されているように、ウェットタイプの脳波計の多くは、脳波計測の際に脳波電極に導電性のジェルを塗布し頭皮に接着させます。

これによって、頭皮と電極の接触部に発生する電気抵抗を抑えることができるのですが、脳波計測後は被験者が頭皮のジェルを洗い落とす必要があり、手軽に計測ができるとは言い難い手法です。

出典:Rapid Fabrication of Low Impedance, 3D Dry Electrodes for Physiological Sensing

https://arxiv.org/abs/2201.03612

これに対し、近年開発と普及が著しく進んでいるのが、先述の非侵襲型デバイスに含まれるドライタイプの脳波計です。

ドライタイプは様々な形状のものが開発されておりますが、多くはヘルメットやヘッドバンドのように頭を覆う形状で電極が点在し、その電極を頭皮に接着させるように頭に装着するものです。

ウェットタイプとの大きな違いは、導電性ジェルの塗布が不要な点で、若干ノイズが入ることはあるものの、開発の進歩により前処理を行うことで正確な脳波測定が可能となっております。

AIの応用について

今回ご紹介する「ブレインテック×AI」について、まず「ブレインテック」とは、ブレイン(脳)とテクノロジー(技術)をかけ合わせたワードです。

ブレインテックとはその名の通り、ITの技術を活用して脳の動きのメカニズムを明らかにし、そのメカニズムをITの技術に生かしていくことを意味します。

先述の脳波測定装置は脳のメカニズムを解析する役割を担っており、それらの開発や取り組みが進んでいることから、みなさんもブレインテックというワードを耳にする機会が増えてきているのではないかと思います。

そして、弊社で取り組んでいる「ブレインテック×AI」とは、具体的には脳波の解析情報をAIの学習データとして活用するものです。従来AIの学習データというと、物体認識モデルにおいては、画像に対してOne-hotのラベル付けを行う必要などがありました。

しかし、AIの学習に脳波を活用することで、ヒトの暗黙知をデータとして扱うことができ、ソフトラベルが可能になった点が大きな利点として挙げられます。

「ブレインテック×AI」の可能性

ブレインテックと画像認識

ブレインテックとAIの融合によって連想される可能性として、相手の思いや見ている風景を、言葉を介さず理解できることなどが挙げられるかと思います。

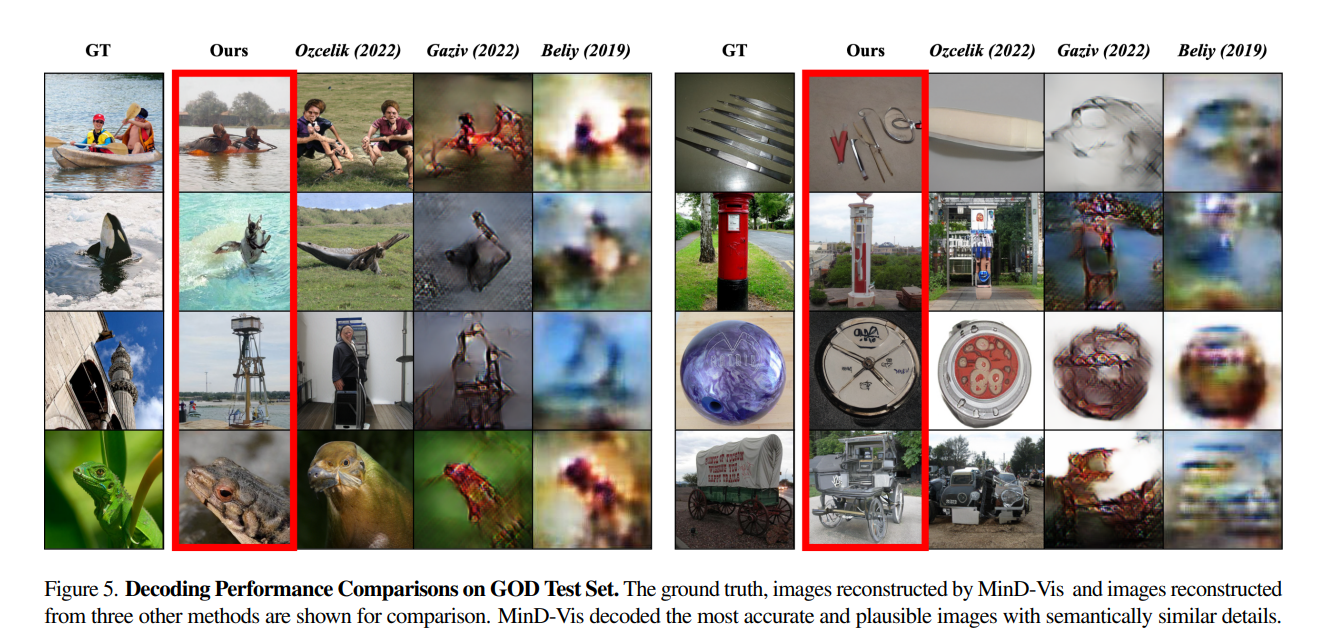

『Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding』では、スタンフォード大学など世界の有名大学3校が共同開発を行った「MinD-Vis」が、既存のモデルより精度の高い結果を出しました。

MinD-Vis(Sparse Diffusion Model for Human Vision Decoding)は、ヒトが画像認識をする際の一次視覚野の活動をfMRIで分析することで、そのヒトが視認している画像の再現を可能にします。これにより、SOTAモデルのベンチマークについては、セマンティック・マッピングにて66%、生成クオリティにて41%、既存モデルの精度を上回る結果となりました。

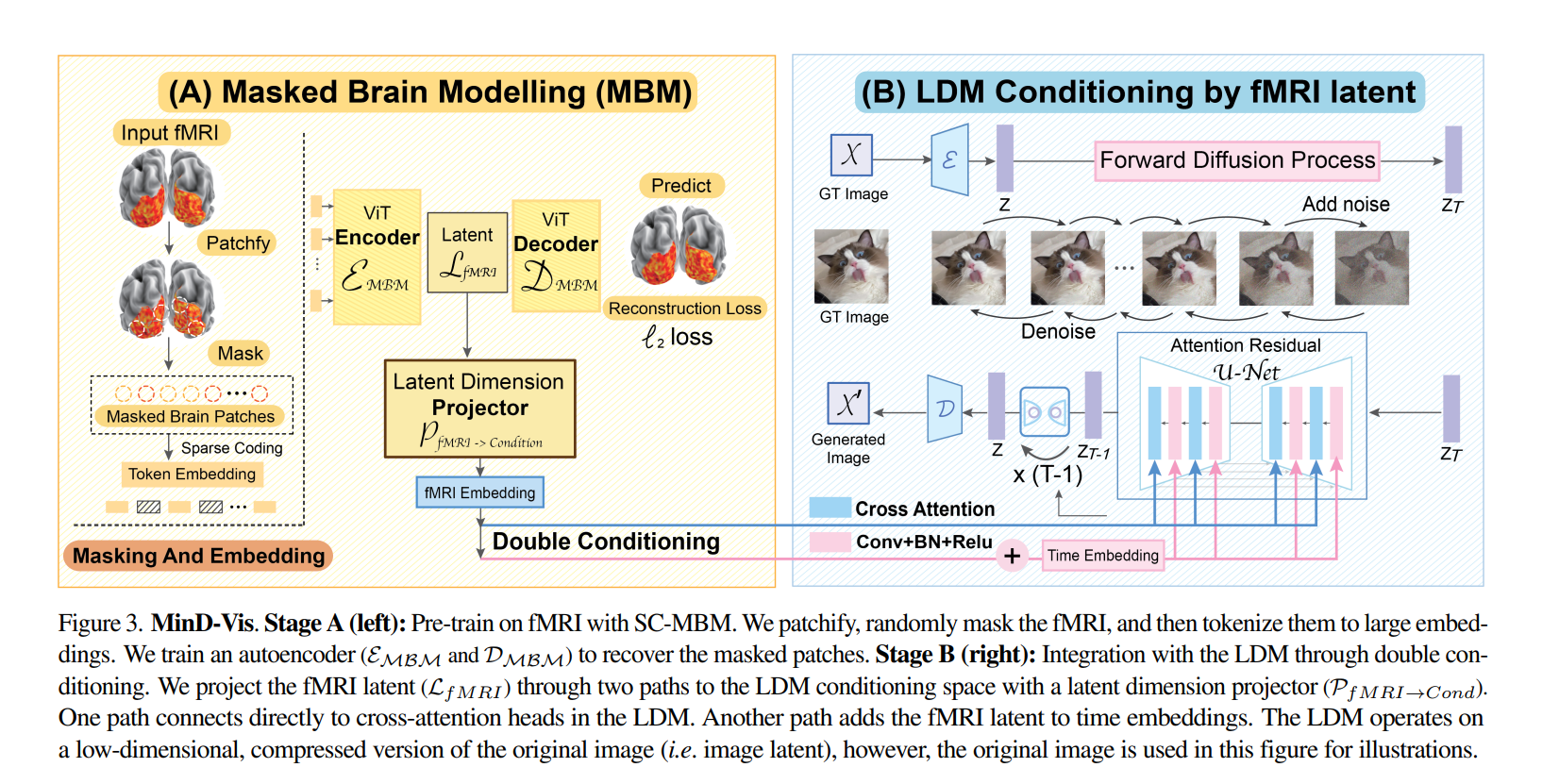

MinD-Visは2つのステップで学習が行われました。

第1ステップのSparse-Coded Masked Brain Modeling(SC-MBM)では、fMRIイメージをベクトル化したボクセルをパッチに分割し、1次元畳み込み層を用いてエンベディングに変換します。次にそれらのパッチをマスク化し、学習能力を保ちながら計算コストを抑えます。最後にマスク化したデータを大きなエンベディングにトークン化し、マスク化したパッチを復元するためオートエンコーダ―を学習させました。

第2ステップのDouble Conditioned Latent Diffusion Models(DC-LDM)では、学習済みLDMに対し、2つの経路を介してfMRIの潜像を与えることで転移学習を行いました。

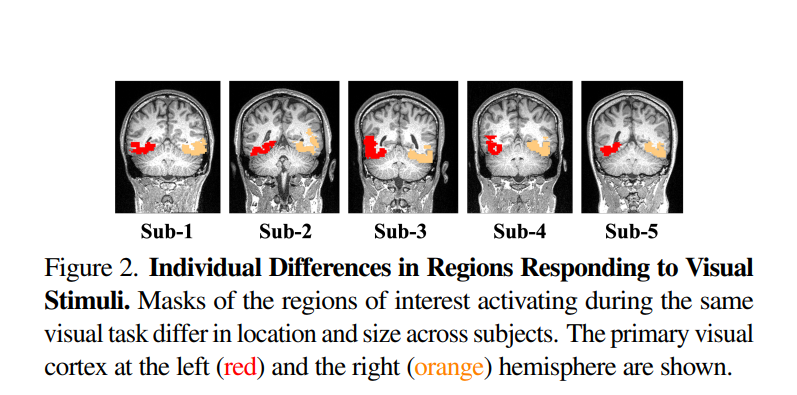

1つ目の経路はLDMのクロスアテンションヘッドに直接接続されています。2つ目の経路はfMRIの潜像に時間情報を加えたものをLDMの中間層に与えるというものです。時間情報を与えるという点は、fMRIの脳活動情報から画像の再現を行うというタスクの中で、学習データにおける脳活動情報の個人差を乗り越えるためのポイントとなります。

このアーキテクチャにより、学習データから全く異なるクラスの評価データにおいて、先述の通りMinD-Visは既存のSOTAモデルを上回る結果となりました。

出典:Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding

キャプション:Figure 3. MinD-Vis. Stage A (left). Stage B (right).

https://arxiv.org/pdf/2211.06956.pdf

出典:Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding

キャプション:Figure 2. Individual Differences in Regions Responding to Visual Stimuli.

https://arxiv.org/pdf/2211.06956.pdf

出典:Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding

キャプション:Figure 5. Decoding Performance Comparisons on GOD Test Set.

https://arxiv.org/pdf/2211.06956.pdf

ヒトの脳活動には個人差があり、AIモデルを学習させるためのデータ取得が課題となりますが、MinD-Visの提案により、個人差のあるデータを学習し、ヒトの脳活動から認識している画像を高精度で再現することができるとわかりました。

この技術の社会実装が進むことで、口語的なコミュニケーションが無くても相手の認識している物体や景色を読み取ることができるようになるなど、様々な壁を越えたコミュニケーションが可能になるでしょう。

ブレインテックと自然言語処理

既に侵襲型の脳波計測装置による文字や単語のデコーディングは研究が進んでいますが、非侵襲型EEGによる自然言語の解析はハードルが高い課題です。

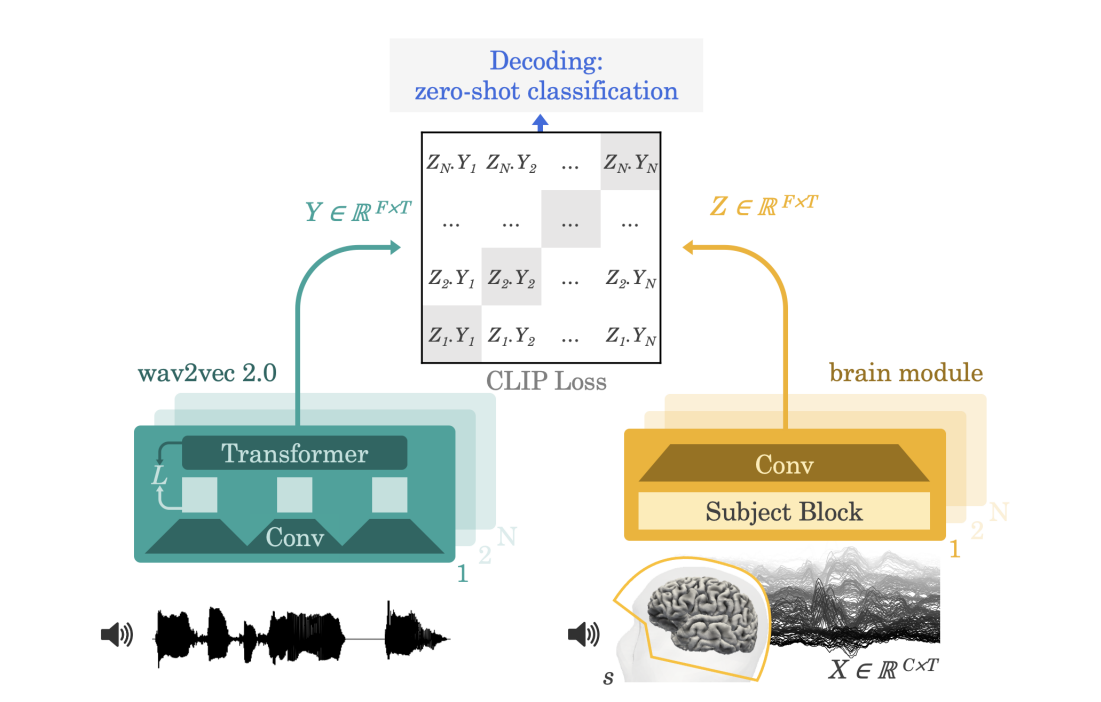

そこでMetaのAIチームが発表した『Decoding speech from non-invasive brain recordings』では、大規模なデータを用いた自己教師ありの学習モデルが提案されました。

出典:Decoding speech from non-invasive brain recordings

キャプション:Figure 1: Method

https://arxiv.org/pdf/2208.12266.pdf

提案されたアーキテクチャは、自己教師ありモデル(wav2vec 2.0)から3秒間の音声信号の文脈表現を抽出し、それに整合する脳活動から畳み込みネットワークによって得た表現を学習させるというものです。

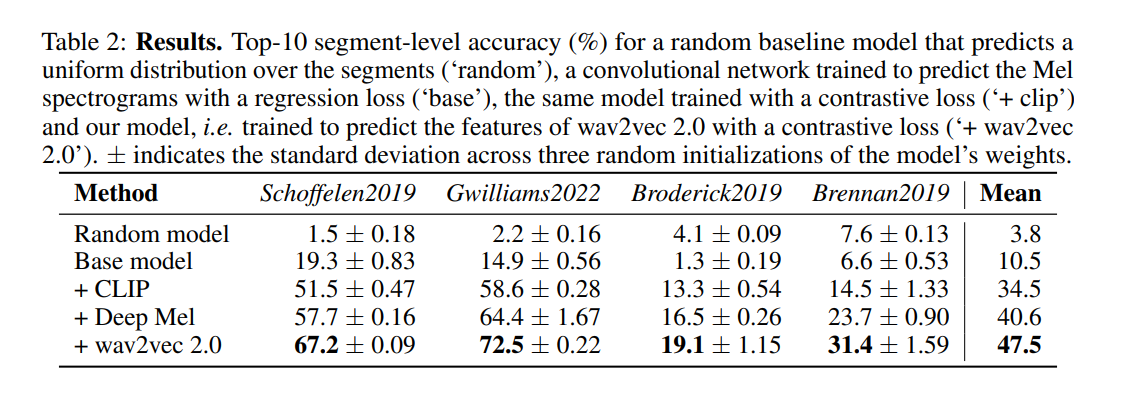

学習には1セグメントを3秒間として約2万セグメント分のMEG、EEGの脳活動データが活用されました。モデル評価には学習データに活用されなかった文章を使用することから、ゼロ・ショット学習と同意義であり、より実用的なアプローチとなります。モデルの学習により、MEGの学習データからは精度67.2、72.5で比較モデルより良い結果が出ており、EEGの学習データは19.1、31.4と低いスコアとなったものの、他モデルの4倍を上回る結果となりました。

本論文で高い結果を出したMEGは、サイズが大きく汎用性は未だ低いものの、ハードウェアの開発が進むことで、AIとの組み合わせにより、コミュニケーション不全の患者の言語処理を診断、予後、回復するなど、活用が大きく広がるでしょう。

出典:Decoding speech from non-invasive brain recordings

キャプション:Table 2: Results.

https://arxiv.org/pdf/2208.12266.pdf

ブレインテック精神疾患診断

最後に、ブレインテックの分野で欠かせないのが神経疾患へのアプローチです。特にAIとの融合による複雑な神経疾患の診断は、近年注目されているトピックです。

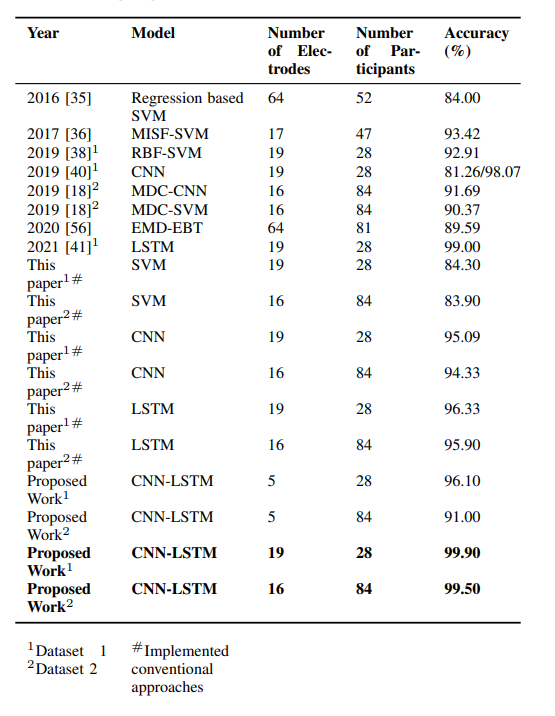

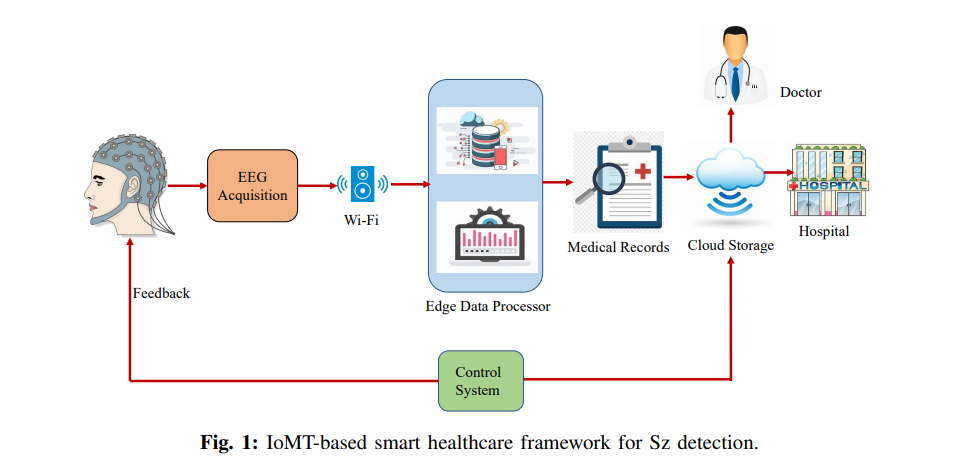

IEEEのメンバーである著者が発表した「Novel EEG based Schizophrenia Detection with IoMT Framework for Smart Healthcare」では、EEGから取得した脳活動情報について、畳み込みネットワーク(CNN)とLong Short Term Memory(LSTM)の複合モデルにより、統合失調症の診断精度が格段に良くなり、医療分野のIoT(IoMT)に実装可能だと検証されました。

出典:Novel EEG based Schizophrenia Detection with IoMT Framework for Smart Healthcare

キャプション:Fig. 1: IoMT-based smart healthcare framework for Sz detection.

https://arxiv.org/pdf/2111.11298.pdf

モデルの学習は、統合失調症患者とコントロール群、それぞれの被験者のEEG信号を学習データとしました。本論文では統合失調症の診断において、特徴の自動抽出のためにCNNを、統合失調症を分類するためにLSTMを活用しました。

学習の結果、提案されたモデルは、32チャネルのEEGを活用した場合、統合失調症の診断精度が99.9%であり、5チャネルの場合は96.1%の結果となりました。これは既存の他モデルと比べても良い結果で、少ないチャネル数、つまり簡易的かつ汎用性の高いEEGでも精度の高い診断が可能だということがわかりました。

今後は学習データを増やすことで、さらに強固なモデルに改善することが可能だとされており、モデルの評価時には医療現場でのリアルタイムの診断で評価をすることも示唆されています。

出典:Novel EEG based Schizophrenia Detection with IoMT Framework for Smart Healthcare

キャプション:TABLE XI: Comparison of accuracy among proposed, implemented conventional deep learning/machine learning approaches and the previous works (Best results are highlighted).

https://arxiv.org/pdf/2111.11298.pdf

今回は、脳波の解析から画像認識や言語認識、疾患の診断に渡る「ブレインテック×AI」の様々な事例を紹介しました。今回紹介した事例は、「ブレインテック×AI」の一部にすぎませんが、医療分野など様々な実用可能性がご理解いただけたかと思います。

ヒトの脳活動を解析し、それを生かした技術応用は未来の話のようですが、社会実装は着実に進んでいます。デバイスの開発やAIモデルの進化など、今後さらに発展していく分野となるでしょう。

|

■ 本ページでご紹介した内容・論文の出典元/References https://arxiv.org/abs/2201.03612 https://arxiv.org/pdf/2211.06956.pdf https://arxiv.org/pdf/2208.12266.pdf |

無料デモンストレーション

デモンストレーションのご案内

実際に脳波を測定してみませんか?

脳波をベースにした「熟練者の技能伝承」とは?人間の意識、判断を学習するAIとは?

不明なことが多いかと思いますので、まずは脳波を測定してどんなものかを体験してみませんか?

実際に測定後、今までの私たちの活動でのAI活用事例を交えながら、よりお客様の現場で脳波を使ったAIを活用していけるようにご提案から、実装、運用までサポートさせていただきます。

詳細はこちら

資料ダウンロード

カタログ、ホワイトペーパーなど本システムに関して詳細を記載しておりますので、詳細を知りたい方はこちらから資料をダウンロードしてください。

お問い合わせ

本記事に関してご質問などありましたら、以下よりお問い合わせください。